Serviços Personalizados

Journal

Artigo

Indicadores

-

Citado por SciELO

Citado por SciELO -

Acessos

Acessos

Links relacionados

-

Similares em

SciELO

Similares em

SciELO

Compartilhar

Análise Social

versão impressa ISSN 0003-2573

Anál. Social no.204 Lisboa jul. 2012

O contributo das ciências sociais para a análise de acidentes maiores: dois modelos em confronto

The contribution of social sciences to analysis of major accidents: two models in comparison.

João Areosa*

*Universidade do Minho. E-mail: joao.s.areosa@gmail.com

Resumo

Os acidentes maiores são um problema social relevante, dado que podem afetar alguns pilares importantes das sociedades contemporâneas, como as populações, as infraestruturas ou as próprias organizações onde estes eventos ocorrerem. Este tipo de acidentes surge em organizações de alto-risco, onde interagem, entre outros, aspetos de natureza técnica, tecnológica, social e organizacional. Neste artigo confrontamos a perspetiva das organizações de alta fiabilidade e a teoria dos acidentes normais, explorando as principais virtudes e limites de cada um destes modelos. Iremos verificar que o seu modo de compreender os acidentes, bem como as formas de prevenção propostas são parcialmente antagónicos.

Palavras-chave: acidentes maiores; prevenção de acidentes; organizações de alta fiabilidade; teoria dos acidentes normais.

Abstract

Major accidents are a relevant social problem, because they can affect certain important pillars of contemporary societies such as population, infrastructures, and the very organizations in which the events occurred. Major accidents arise in high-risk organizations, where technical, technological, social, and organizational factors interact. In this paper we confront the theory of High Reliability Organizations (HRO) and the Normal Accidents Theory (NAT), exploring the virtues and limitations of each model.

Keywords: major accidents; accident prevention; high-reliability organizations; normal accident theory.

ORGANIZAÇÕES DE ALTA FIABILIDADE: SUCESSO OU INSUCESSO PERANTE OS ACIDENTES?

As organizações existem, essencialmente, para desempenhar uma função social útil. Este é o seu lado positivo e benéfico. Porém, se observarmos a perspetiva de Max Weber (1947), torna-se claro que as organizações representam o arquétipo da racionalização ou o tipo ideal da burocracia (características que as tornam eficientes), mas, simultaneamente, podem também produzir resultados inesperados (o designado paradoxo das consequências), cujos efeitos podem ainda transformar-se num verdadeiro colete-de-forças, passível de oprimir e aprisionar a humanidade. A visão pessimista do autor resulta, em parte, do seguinte entendimento: a disciplina imposta pela burocracia limita fortemente a liberdade individual, o que acaba por originar uma massa de subordinados e uma despersonalização das relações sociais. Para Weber, é difícil conceber a modernidade sem a infiltração da racionalização e da burocratização nas organizações contemporâneas, mas este fenómeno gera no autor um sentimento de desencantamento do mundo. Na mesma linha de pensamento, Merton (1936) refere que as organizações produzem, inevitavelmente, consequências secundárias que vão contra os seus objetivos pré-estabelecidos ou, por outras palavras, são suscetíveis de produzir efeitos não desejados. Segundo Vaughan (1999) este pensamento constitui o pilar de qualquer tipo de considerações sobre o lado negro das organizações.

Parece relativamente consensual que o mundo moderno se encontra repleto de perigos e de riscos, nomeadamente os decorrentes das atuais tecnologias complexas, tal como referem alguns cientistas sociais (Douglas e Wildavsky, 1982; Beck, 1992; Renn, 1992; Giddens, 1998). Segundo LaPorte e Consolini (1991) a partir de meados do século XX emergiram determinadas tecnologias que possibilitaram o aumento dos níveis produtivos, mas cujo poder destrutivo, em caso de acidente, é catastrófico. É importante referir que o funcionamento das organizações que utilizam este tipo de tecnologias é influenciado por múltiplos fatores (internos e externos) que podem afetar a sua resiliência.1 A ocorrência de acidentes maiores é a prova cabal da existência de erros, falhas, ou de circunstâncias dificilmente antecipáveis. Esta ideia inscreve-se e dá sequência às abordagens de Weber e Merton referidas anteriormente.

Os sistemas de alto-risco revelam sempre algumas vulnerabilidades e imperfeições, por isso, como é que poderemos tentar contrariar a ocorrência de situações inesperadas e ameaçadoras nas organizações? Um grupo de investigadores, designado como teóricos da alta fiabilidade organizacional, acredita que é possível manusear tecnologias complexas e perigosas sem originar grandes acidentes.2 Considerando então a existência e utilização de tecnologias de alto-risco pela humanidade, quais serão os principais argumentos, utilizados pelos teóricos das organizações de alta fiabilidade (High Reliability Organizations – HRO), para afastar os medos públicos e privados acerca dos eventuais cenários de acidentes maiores ou desastres de larga escala? Contrariar estes receios parece, à partida, uma tarefa difícil.3 Sagan (1993) interroga-se se serão este tipo de acidentes preveníveis? Ou se serão eles uma inevitável consequência das tecnologias perigosas do mundo moderno? Se tivermos em conta a complexidade de algumas organizações, em que podem ocorrer, em certos casos, interações não-lineares, parece mera utopia colocar a hipótese de que é possível prever e prevenir todos os tipos de acidentes. Apesar de raros, os acidentes maiores parecem inevitáveis; este é um dos motivos pelo qual se considera este tipo de eventos como algo normal (Perrow, 1999 [1984]). No entanto, Roberts (1990, p. 173) afirma que as HRO encontraram diversas estratégias para evitar os efeitos negativos provocados por algumas características estruturais destes sistemas, nomeadamente, as interações complexas e as ligações apertadas.

O debate sobre as designadas organizações de alta fiabilidade emerge a partir da longa discussão acerca do acidente de Three Mile Island (TMI).4 Segundo os teóricos das HRO, a fiabilidade pode ser entendida (em sentido metafórico) como a capacidade para produzir repetidamente um resultado particular (neste caso a não ocorrência de acidentes). Algumas pesquisas no âmbito das HRO pretendem demonstrar que é possível e viável recorrer à utilização de tecnologias complexas de alto-risco sem dar origem a acidentes maiores. A capacidade para lidar com este tipo de tecnologias depende, em larga medida, de alguns preceitos organizacionais, tais como designs organizacionais adequados, técnicas de gestão designadas inteligentes, ampla promoção de atividades livres de falhas, forte adaptação a situações limite ou de pico nas atividades e troca de informação entre pares. LaPorte e Consolini (1991) afirmam que as HRO não podem cometer erros graves, dado que os seus efeitos podem dar origem a consequências desastrosas como um elevado número de mortos, catástrofes ambientais suscetíveis de afetar várias gerações, ou ampla destruição de infraestruturas (fundamentais para o funcionamento das sociedades).

A discussão sobre os níveis de segurança em sistemas tecnológicos complexos é um dos temas centrais da teoria das organizações de alta fiabilidade. Aliás, este debate surge como um dos aspetos mais polémicos e controversos entre o modelo da alta fiabilidade organizacional e a perspetiva dos acidentes normais. Tendo ainda como pano de fundo as múltiplas divergências entre ambas as correntes, se, por um lado, a abordagem teórica dos acidentes normais poderia ser acusada de transmitir um discurso pessimista perante o controlo dos níveis de segurança organizacional na utilização de tecnologias complexas, por outro lado, a teoria HRO pode ser rotulada de preconizar um excessivo otimismo acerca desta mesma questão. Outra das grandes diferenças entre as duas correntes está na forma como explicam os acidentes; isto é, enquanto a perspetiva dos acidentes normais aprofunda as causas dos acidentes (explicações para estes eventos), a teoria HRO não explica o porquê destes acidentes ocorrerem, mas antes, por que motivo ocorrem com tão pouca frequência. No âmbito deste debate, LaPorte e Consolini (1991) publicaram um artigo com um título bastante sugestivo (Working in practice but not in theory), onde são apresentados alguns dos principais argumentos sobre como é possível lidar com tecnologias perigosas muito complexas e, simultaneamente, manter níveis elevados de performance (incluindo a área da segurança organizacional).

Os mentores teóricos das HRO defendem que determinados sistemas complexos – a aviação (comercial ou militar), a marinha, os sistemas ferroviários, os controladores aéreos, as centrais nucleares, entre outros – apenas representariam um benefício para as sociedades caso a sua performance estivesse próxima de um nível livre de falhas. As HRO dedicam particular atenção à partilha de erros5, visto que as suas consequências podem ser tão grandes que eles têm de ser evitados a qualquer preço. Existe uma forte aposta no recrutamento, na socialização e na missão das HRO, tentando evitar que os lapsos ou contingências individuais possam originar problemas. Os autores das HRO sabem que os relatórios sobre a análise de acidentes maiores apontam normalmente a intervenção humana como o catalisador de luxo para desencadear o acidente (DOliveira, 2006), embora nós corroboremos a perspetiva de que o erro humano deve ser, cada vez mais, entendido como uma consequência da atividade organizacional e não tanto como a principal causa dos acidentes (Reason, 1990; 1997).

Para além disso, as HRO deparam-se, por vezes, com a necessidade imperiosa de ir até ao limite das suas capacidades (devido às necessidades sociais a que tentam responder), e este cenário constitui-se, à partida, como um acréscimo para os níveis de risco da organização, tornando-se num teste (perigoso) à sua resiliência. Todavia, LaPorte e Consolini (1991, p. 29) reiteram que existe uma fictícia contradição no desempenho das organizações de alta fiabilidade, em que o limite das suas capacidades e/ou o reforço da produção (atingindo o seu pico durante um determinado período) pode até coincidir como uma redução dos erros na atividade, devido aos excelentes padrões de tomada de decisão organizacional permitirem suportar este aparente paradoxo (aumento da produção versus redução de erros ou falhas).6

FIABILIDADE NAS HRO

A tecnologia é normalmente indisciplinada e as suas caixas negras são, por vezes, difíceis de decifrar (Wynne, 1988). Segundo a perspetiva de Paul Virilio (1983), toda e qualquer tecnologia é suscetível de produzir acidentes específicos. O autor refere os seguintes exemplos: A invenção dos navios deu origem aos naufrágios; a criação da locomotiva possibilitou os descarrilamentos; e a invenção dos aviões permitiu os desastres aéreos. Por este motivo, a continuidade do desenvolvimento tecnológico implica que teremos de pensar mais nas suas consequências, incluindo o tipo de acidentes que podem provocar. Contudo, nas HRO a fiabilidade passa por articular de forma meticulosa os seguintes quatro aspetos:

1. Consenso entre a performance das tarefas e os objetivos de segurança;

2. Promoção de uma forte cultura de responsabilidade na organização, onde os trabalhadores são socializados e treinados para responder às situações de crise e emergência (controlo hierárquico centralizado perante situações normais e descentralizado em momentos de crise);

3. Utilização de formas sofisticadas de aprendizagem organizacional (incluindo o relato imediato de erros, falhas ou lapsos) e sensibilidade nos julgamentos e na gestão da organização;

4. Recurso extensivo a formas redundantes nos múltiplos componentes sistémicos, bem como nas diversas atividades da organização.

Um dos grandes desafios que se coloca a quem tem de construir sistemas fiáveis (em particular quando estão envolvidas tecnologias complexas perigosas) é precisamente a sua idealização/construção, a qual ocorre, por vezes, a partir de componentes ou partes com menor fiabilidade. Ou seja, será possível construir sistemas fiáveis a partir de subsistemas menos fiáveis? Segundo os teóricos das HRO a resposta é indubitavelmente afirmativa. Esta dificuldade (tentar criar a perfeição através de partes imperfeitas) é normalmente ultrapassada através da redundância (sistemas paralelos), isto é, mediante a duplicação sistémica para a mesma função (em caso de falha da primeira unidade atua a segunda). Deste modo, a redundância pode ser vista como um mecanismo protetor perante a ocorrência de falhas. Porém, segundo Sagan (1993, p. 251) temos algumas evidências históricas que demonstram a inadequação de tentar assegurar a fiabilidade a partir da criação de mais e mais partes redundantes nos sistemas. Aliás, Sagan (2004) refere ainda três aspetos em que a redundância pode produzir menos (e não mais) fiabilidade dentro das organizações:

1. Os dispositivos (de segurança) redundantes tornam os sistemas mais complexos e podem produzir novos erros e falhas.

2. A colocação de novos dispositivos redundantes leva, tendencialmente, a que exista uma menor atenção, vigilância, e responsabilidade por parte dos membros da organização, dado que esta situação gera a sensação de que o sistema se tornou mais seguro.

3. Por último, a redundância pode também ampliar a confiança das hierarquias sobre a fiabilidade do sistema, e isto pode gerar maiores pressões sobre os trabalhadores para aumentarem a produção; mas esta situação reduz, por vezes, as condições de segurança.

Tal como já foi afirmado anteriormente, a redundância organizacional7 é uma das principais características das HRO. Na perspetiva de LaPorte e Consolini (1991) as HRO encontraram nos princípios da redundância um dos seus melhores trunfos para obter desempenhos fiáveis (mesmo sendo operadas por seres humanos suscetíveis de cometerem erros e/ou falhas ou contendo componentes menos fiáveis). Estas organizações promovem a partilha dos seus erros e desvios, mas ao contrário de outras organizações conseguem corrigir esses mesmos erros quase de imediato. Isto só se torna possível, por exemplo, devido a uma vigilância rigorosa e a uma sobreposição de tarefas e competências dos seus trabalhadores. Eles são capazes de detetar e corrigir os erros dos seus pares, visto que a cultura organizacional está assente na deteção de falhas, pois os mais pequenos erros podem dar origem a acidentes de larga escala. Para além disso, os trabalhadores mantêm um contacto direto (olhos-nos-olhos) uns com os outros (visto que existe uma forte aposta, por parte da organização, no contacto informal8 e aberto entre trabalhadores), permitindo uma fácil comunicação entre todos os membros da organização. As HRO procuram que o conhecimento técnico dos seus membros seja o mais completo possível.9 É por isso que dedicam particular atenção às subtilezas comportamentais dos seus sistemas sociotécnicos, e exercem uma forte vigilância sobre as armadilhas que podem estar por detrás de algumas tomadas de decisão, visto que uma pequena falha ou uma ligeira dose de indecisão (por exemplo, fruto de alguma incerteza10) podem causar efeitos adversos. Naturalmente que os elevados níveis de segurança e fiabilidade nestas organizações não se enquadram dentro de padrões económicos baratos, mas a aceitabilidade social destas organizações depende, em parte, destas características.

AS DIMENSÕES DA REDUNDÂNCIA ORGANIZACIONAL

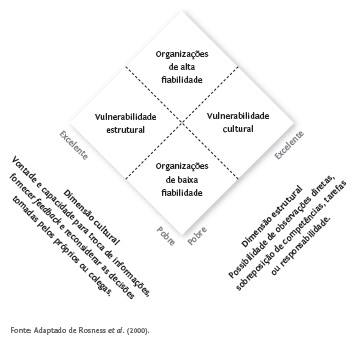

Rosness et al. (2000) preconizam que a rápida recuperação nas situações de erro ou falha se deve à redundância organizacional, que, por sua vez, tal como demonstra a figura 1, depende de duas dimensões essenciais: as pré-condições estruturais/instrumentais e as pré-condições culturais. A dimensão estrutural está relacionada com a possibilidade de os trabalhadores observarem o trabalho uns dos outros, corrigindo eventuais erros (mas sem que isto possa originar atritos ou a perda de confiança mútua); está também assente na sobreposição de tarefas, competências e responsabilidades. Algumas organizações constroem a sua robustez estrutural e resiliência a partir da distribuição do poder de veto por alguns dos seus membros, particularmente em situações onde a inação pode ser mais segura do que a ação (Schulman, 1993). Outro aspeto relevante é a qualidade e diversidade dos canais de comunicação neste tipo de organizações, embora também exista uma forte aposta na comunicação informal entre os diversos membros da organização (tal como é demonstrado na dimensão seguinte).

Figura 1 - As duas dimensões da redundância organizacional

A dimensão cultural da redundância organizacional está em grande parte dependente da vontade e capacidade para a troca de informação entre todos os colaboradores. Uma das formas de obter a informação pode passar por dedicar uma atenção especial à avaliação dos feedbacks emitidos pelo próprio sistema. As HRO promovem a troca de informação organizacional porque isso permite aos seus trabalhadores reconsiderarem as suas próprias decisões ou ajudarem os seus pares a reconsiderá-las, ou seja, isto possibilita uma rápida intervenção na recuperação de falhas ou ações erradas. Normalmente os trabalhadores têm iniciativa para identificar e melhorar as eventuais deficiências nos procedimentos utilizados quer nas operações regulares, quer nas situações de trabalho raras ou excecionais. Nas HRO, a dimensão cultural da redundância organizacional promove também uma atitude responsável (não laxista) dos seus colaboradores relativamente ao relato de erros, falhas ou outros sinais anómalos encontrados no funcionamento do sistema, sem, no entanto, que isto se torne contra-produtivo ao nível da autonomia individual e da necessária confiança entre pares. Por último, as HRO conseguem, segundo os seus principais teóricos, alterar e flexibilizar a sua estrutura hierárquica formal, em situações de crise, transferindo a responsabilidade das decisões para quem tem um verdadeiro conhecimento empírico dentro da organização. Autores como LaPorte e Consolini (1991) acusam Perrow (1999 [1984]) de não ter dado atenção a este aspeto quando concebeu o seu modelo dos acidentes normais.

A NOÇÃO DE MINDFULNESS

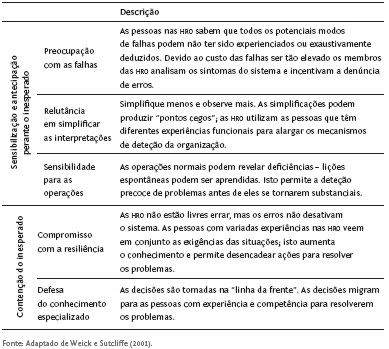

O debate sobre as características das HRO não ficou confinado aos anos subsequentes ao acidente de Three Mile Island, visto que ainda nos dias de hoje esta discussão se mantém viva.11 Recentemente foi introduzida a noção de mindfulness12 para identificar uma das características mais proeminentes das HRO. Os teóricos das HRO sabem que é impossível eliminar todas as falhas dentro destas organizações, por isso existe uma profunda necessidade de gerar saberes e conhecimentos para detetar atempadamente os erros e falhas (preferencialmente logo após a sua ocorrência, ou sempre que possível antecipando-os antes da sua efetivação). É por este motivo que Weick e Sutcliffe (2001) apresentaram a ideia de mindfulness como algo equivalente a uma constante vigilância sobre o funcionamento das organizações, de modo a que os seus membros possam intervir rapidamente caso isso seja necessário. Assim, a noção de mindfulness está relacionada com a deteção e contenção de eventos inesperados e/ou sem precedentes, passíveis de surgirem em qualquer lugar da organização e suscetíveis de causar efeitos não desejados (particularmente acidentes). Vejamos, através da tabela 1, quais os principais elementos da noção de mindfulness preconizados pelos autores.

Tabela 1 - Descrição dos principais elementos da noção de mindfulness

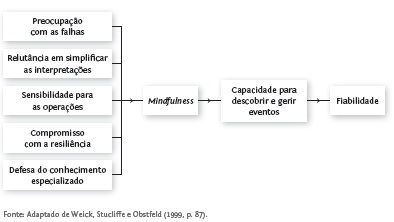

Segundo Weick e Sutcliffe (2001) a ideia de mindfulness pode ser vista como uma das características universais das HRO, dado que esta conceção tem subjacente o reforço da sensibilização para antecipar e detetar situações não previstas. Porém, uma das críticas apontadas a esta noção relaciona-se com a reduzida importância que os seus autores atribuíram às características específicas da tecnologia utilizada por cada organização, tendo em conta que este é um aspeto decisivo para se poder alcançar a fiabilidade organizacional, tal como é sugerido por Perrow (1999 [1984]) na teoria dos acidentes normais. Para além disso, é dado pouco destaque ao facto de os trabalhadores poderem ter visões e comportamentos distintos perante os perigos, os riscos e as ameaças, tal como observou Granjo (2004) na sua pesquisa sobre Sines. Assim, a perspetiva de Weick e Sutcliffe (2001), parece esquecer estes pressupostos, como se pode ver pela esquematização da figura 2 sobre a fiabilidade organizacional.

Figura 2 - Infraestrutura da alta fiabilidade organizacional

Por mais fiável que um sistema se apresente, isto não significa a total ausência de falhas. Mas segundo Weick, Stucliffe e Obstfeld (1999) o processo de mindfulness tenta suprimir uma certa tendência para a inércia, tendo em conta que esta infraestrutura cognitiva permite, simultaneamente, uma aprendizagem adaptativa e uma performance fiável. Este processo permite reduzir os pontos cegos dentro da organização, que por sua vez iriam possibilitar a acumulação de falhas (passíveis de resultar em catástrofe). Subjacente à conceção de mindfulness está o intercâmbio de informação entre os membros da organização, onde a troca de ideias é um aspeto valorizado, ou, recorrendo às palavras de Westrum (1993, p. 405) os trabalhadores têm licença para pensar.13 Em resumo, a capacidade de mindfulness permite, alegadamente, a projeção, a descoberta e a correção de eventos inesperados passíveis de originar acidentes maiores.

A TEORIA DOS ACIDENTES NORMAIS

Na perspetiva de Charles Perrow (1991), as organizações atuais dominam uma parte significativa do funcionamento das sociedades contemporâneas, visto que absorveram diversos campos importantes das interações sociais. Para o autor vivemos numa era em que reina o imperialismo organizacional. Entre muitos outros aspetos, a teoria social sobre as organizações ajuda-nos a compreender como é que as estratégias organizacionais podem contribuir ou influenciar a ocorrência de acidentes, particularmente dos acidentes de grandes dimensões. Os acidentes maiores, designados na teoria de Perrow como acidentes sistémicos ou acidentes normais,14 converteram-se num problema de difícil resolução para as sociedades atuais. A espetacularidade de alguns acidentes com estas características transformaram-nos em eventos fortemente mediatizados, dando origem a uma amplificação social dos riscos tecnológicos produzidos pelo homem. Segundo Perrow (1999 [1984]), alguns sistemas ou organizações, designados de alto-risco (por incorporarem, por exemplo, sistemas tecnológicos complexos), possuem determinadas propriedades estruturais que tornam certos tipos de acidentes virtualmente impossíveis de prever e evitar. Assim, no âmbito dos sistemas de interações complexas15 os acidentes constituem-se como eventos normais. Um dos aspetos que caracteriza os acidentes normais é a sua incompreensibilidade, devido à interação inesperada de múltiplas falhas.

A teoria dos acidentes normais16 pode ser vista como uma visão contrária ou concorrente ao modelo apresentado anteriormente. Porém, ambas as perspetivas emergem do amplo debate que se seguiu ao acidente de Three Mile Island. Segundo Perrow, as organizações que possuem sistemas tecnológicos complexos já provaram que não dispõem de condições para eliminar todos os acidentes maiores. A ocorrência de alguns acidentes de grandes dimensões e com forte impacto social, tais como Flixborough (Inglaterra, 1974), Seveso (Itália, 1976), Three Mile Island (Estados Unidos, 1979), Bhopal (Índia, 1984), Chernobyl (Ucrânia, 1986), Piper Alfa (Reino Unido, 1988) ou Avianca (Estados Unidos, 1990), vieram suscitar uma certa desconfiança pública em relação a estes sistemas. É com alguma dose de ironia que Perrow profetiza boas e más notícias sobre a questão dos acidentes. As boas notícias são as seguintes: se nós conseguirmos conhecer melhor a ampla natureza dos riscos organizacionais, por exemplo, através da investigação de acidentes, é possível que se consigam reduzir ou eliminar alguns tipos de perigos; embora o autor revele bastante cepticismo acerca da efetiva aprendizagem organizacional perante este tipo de acidentes.17 As más notícias vaticinam que acidentes com estas características irão voltar a acontecer no futuro.

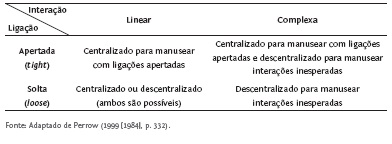

Na ótica de Perrow (1999 [1984], p. 19), os acidentes sistémicos envolvem, por vezes, alguns mistérios. A conceção estrutural das organizações de alto-risco foram geradas a partir de designs tão complicados que se torna impossível antecipar todas as interações entre possíveis falhas. Os dois fatores mais importantes para a produção de acidentes normais são a high complexity e o tight coupling. O primeiro fator está relacionado com a elevada complexidade do sistema, o qual gera potencial suficiente para ocorrerem interações imprevisíveis, enquanto o segundo está relacionado com as ligações apertadas (malha estreita ou acoplamento forte) entre os diversos componentes do sistema. Esta apertada interconetividade estrutural do próprio sistema permite ou facilita a rápida e incontrolada propagação de eventos indesejados, em que os componentes que falharam dificilmente podem ser desligados ou isolados dos restantes, devido às características internas do próprio sistema. No entanto, a observação quer do tipo de propriedades internas (interações e ligações), quer da estrutura organizacional de controlo (centralizado versus descentralizado), podem fornecer dados relevantes para as análises de acidentes. Para Perrow (1999 [1984]), as organizações que simultaneamente apresentam interações complexas e ligações apertadas podem tornar-se um forte dilema para os seus gestores (v. tabela 2), devido à necessidade de utilizar estruturas centralizadas para umas situações e descentralizadas para outras.

Tabela 2 - Sistemas de gestão e controlo organizacional

É referido por Perrow (1999 [1984]) que os sistemas com interações complexas apenas podem ser efetivamente controlados através de uma estrutura organizacional descentralizada. A elevada interatividade dentro dos sistemas complexos dá origem a diversas tarefas não rotineiras, dificilmente programáveis ou estandardizáveis. Pelo contrário, os sistemas com ligações apertadas devem ser controlados internamente a partir de uma estrutura organizacional centralizada. Uma falha ou perturbação numa organização com estas características pode propagar-se rapidamente por todo o sistema. Assim, é necessário ter uma estrutura de controlo organizacional centralizada para que, em caso de falha, se possa atuar de forma rápida, visto que as estruturas de controlo descentralizado são passíveis de gerar alguns conflitos de opinião (por sua vez incompatíveis com a necessidade de uma atuação rápida). Em resumo, um dos grandes dilemas na gestão das organizações que apresentam conjuntamente as características de interações complexas e de ligações apertadas é não poderem ter, em simultâneo, processos decisórios centralizados e descentralizados. Este é um dos motivos pelo qual o autor indica que os sistemas com estas características deveriam ser modificados ou, em certos casos, abandonados.

A obra de Perrow (1999 [1984]) sugere a distinção entre os acidentes sistémicos e os eventos menores ou pequenos acidentes. Numa perspetiva com alguns aspetos semelhantes, Reason (1997) também distingue os acidentes individuais dos acidentes organizacionais.18 Os eventos menores, preceituados por Perrow, não são mais do que as designadas falhas nos componentes que possibilitam a ocorrência de acidentes ligeiros. Quando os eventos menores são provocados pela falha de um dos componentes do sistema19 eles não traduzem, normalmente, nenhuma interação inesperada e, regra geral, podem até ser detetados antecipadamente, como por exemplo, através das metodologias de análise de riscos. Estas falhas, incidentes ou pequenos acidentes não constituem geralmente motivo de grande preocupação para os diversos agentes sociais da organização, pois são facilmente ultrapassáveis e não costumam provocar grandes lesões, danos ou prejuízos. Porém, o grande enigma destes eventos menores é que eles podem significar que algo não está bem dentro da organização.

Podemos considerar estes eventos menores como pequenos sinais de alerta para ameaças potencialmente maiores, mas o maior perigo de todos é a rápida interação entre falhas aparentemente desconectadas, sem ligação visível, mas que acabam por interagir surpreendentemente em determinadas circunstâncias excecionais.20 Estas interações de falhas podem assumir um efeito de cascata ou efeito dominó, sem possibilidade de controlo, devido ao seu rápido desenvolvimento e à proximidade dos diversos componentes do sistema (partes, unidades ou subsistemas). Estes efeitos são difíceis de controlar não apenas porque são constituídos por diversos componentes, mas principalmente porque as interações entre componentes são não-lineares. Vejamos, agora, qual a definição que o autor preconiza para distinguir os dois tipos de acidentes atrás referenciados:

Component failure accidents and system accidents are distinguished on the basis of whether any interaction of two or more failures is anticipated, expected or comprehensible to the persons who designed the system, and those who are adequately trained to operate it. A system accident, in our definition, must have multiple failures, and they are likely to be in reasonably independent units or subsystems. But system accidents, as with all accidents, start with a component failure, most commonly the failure of a part, say a valve or an operator error. It is not the source of the accident that distinguishes the two types, since both start with component failures; it is the presence or not of multiple failures that interact in unanticipated ways [Perrow, 1999 (1984), pp. 70-71].

Já afirmámos anteriormente que para os autores das HRO a redundância é um fator-chave na prevenção de acidentes. Porém, na ótica de Perrow, os sistemas redundantes e os dispositivos de segurança que supostamente deveriam proteger estes sistemas podem acrescentar ainda maior complexidade ao próprio sistema, tornando-o mais opaco. A opacidade dos sistemas complexos revela dois aspetos essenciais: o desconhecimento sobre aquilo que pode vir a acontecer, e a incompreensão sobre aquilo que o sistema pode fazer (Reason, 1990, p. 179). Esta situação pode confundir os trabalhadores que operam o sistema, tornando algumas falhas intratáveis. A maior preocupação relacionada com os acidentes normais acaba por estar situada nos danos ou prejuízos causados e não tanto na frequência da sua ocorrência. Todavia, considerando algumas características aleatórias, desconhecidas e/ou disfuncionais dos sistemas hiper-complexos, aliada à fraca experiência histórica em lidar com estas novas realidades, Perrow (1999 [1984]) interroga-se sobre o motivo pelo qual não ocorrem mais acidentes deste tipo. É recorrendo um certo tom profético em que o autor acaba por vaticinar que acidentes como o de Three Mile Island irão voltar a acontecer no futuro. Na sua opinião, a probabilidade de acontecer um novo acidente sistémico não é de um para um milhão de anos, mas antes, de um durante a próxima década. O prognóstico de Perrow não foi nada tranquilizador, mas se considerarmos a data da publicação original do seu livro (1984) e a data do desastre de Chernobyl (1986) verificamos que a sua intuição estava correta.

DUAS PERSPETIVAS EM CONFRONTO: POTENCIALIDADES E LIMITES DE CADA MODELO

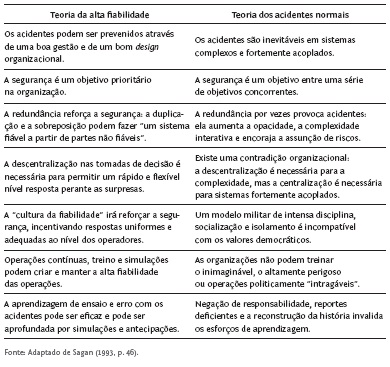

Ironicamente, Sagan (1993) interroga-se sobre como é que as HRO podem ter tanto sucesso, dado que incorporam homens imperfeitos, que trabalham em organizações imperfeitas, onde são manuseadas máquinas imperfeitas? Será que a humanidade conseguiu realmente construir organizações suficientemente fiáveis ao nível da segurança, ou, pelo contrário, temos tido muita sorte por não haver mais acidentes de grandes dimensões? O autor tenta responder a estas e outras questões recorrendo ao confronto entre a teoria dos acidentes normais e a teoria das organizações de alta fiabilidade. De facto, parece indiscutível que a obra de Sagan (1993) apresentou de forma extraordinária as virtudes e limites de ambos os modelos, tornando-os bastante mais maduros do ponto de vista científico. A tabela 3 apresenta as principais diferenças entre ambas as teorias.

Tabela 3 - Diferenças na abordagem aos sistemas de alto-risco

A partir da tabela anterior podemos verificar que muitas das condições que os mentores das HRO preconizam como elementos fundamentais para promover a segurança organizacional são vistas por parte dos teóricos dos acidentes normais como fatores que podem reduzir essa mesma segurança. Esta oposição valorativa é notória em diversos aspetos. Existe ainda um outro contraste entre a teoria das organizações de alta fiabilidade e a teoria dos acidentes normais, ou seja, é postulado pelos teóricos das HRO que um determinado conjunto de preceitos ou mecanismos (já apresentados anteriormente) conseguem por si só assegurar a fiabilidade organizacional, independentemente do tipo de tecnologia utilizada e do ambiente externo da organização. Pelo contrário, a teoria dos acidentes sistémicos afirma que uma determinada performance fiável ao nível da segurança organizacional estará sempre dependente das propriedades intrínsecas do sistema sociotécnico, logo não existem fórmulas universais de prevenção. Da comparação efetuada por Sagan (1993) entre ambas as teorias é ainda sugerido que a teoria dos acidentes normais é mais sustentada do ponto de vista estrutural e político, posição que corroboramos em absoluto.21

Segundo Rasmussen (1994), a teoria das organizações de alta fiabilidade e a teoria dos acidentes normais podem ser mais compatíveis do que a análise de Sagan (1993) sugere. O autor assegura que nem Perrow afirma que a redundância deve ser evitada nos sistemas de alto-risco, nem os mentores das HRO preconizam que estas organizações nunca falham.22 Paralelamente a esta discussão, Rasmussen afirma que a redundância pode ser algo difícil de gerir nas organizações e a vontade para mantê-la pode baixar drasticamente em períodos de elevada competitividade. No entanto, a utilização da redundância em organizações de alto-risco é essencial para o seu funcionamento e para a manutenção de padrões elevados de segurança (Rasmussen, 1994).

Uma das críticas feita à teoria das HRO relaciona-se com o facto de estes autores considerarem, por exemplo, que os níveis elevados de redundância organizacional são a causa da excelente performance de segurança na organização. Segundo os teóricos do modelo dos acidentes normais, a crença de que uma gestão e um design organizacional inteligentes são fatores suficientemente fortes para operar com tecnologias de alto-risco de forma segura é uma mera ilusão (Sagan, 1993, p. 28). O seu otimismo é também apontado como algo exagerado, devido à existência de determinadas condições impossíveis de antecipar e que podem assumir um efeito dominó e originar acidentes. A incerteza incorporada no funcionamento das HRO é algo transversal às suas dimensões técnicas, tecnológicas, organizacionais e sociais, e isto é também uma condição que não joga a favor da segurança e fiabilidade deste tipo de organizações. Segundo Perrow (1999 [1984]), o sucesso da improvisação em situações de crise e de emergência será sempre limitado, ao contrário daquilo que é afirmado pelos teóricos das HRO. São também utilizadas por LaPorte e Consolini (1991, p. 23) as noções de alto-perigo e baixo-risco para definir e caracterizar as HRO; quanto a nós, estas noções são contraditórias e não podem ser utilizadas em simultâneo para caracterizar a mesma realidade, visto que os riscos decorrem dos perigos, logo quando um perigo é alto, o risco também o será. Na melhor das hipóteses, será aceitável a subdivisão do risco em baixa-probabilidade versus altas-consequências e alta-probabilidade versus baixas-consequências (Kasperson et al., 2000, p. 232). Para além disso, tal como Weick (1990) dá a entender, a interação de dois riscos23 tende a ser um fator multiplicativo em vez de aditivo.

A título de exemplo, outra das críticas que pode ser apontada às HRO diz respeito à ligação entre a estrutura fortemente autoritária e hierarquizada de certas organizações e a possível ocorrência de acidentes (Sagan, 1993, p. 254). O autor afirma que a disciplina extrema de certas instituições pode originar um excessivo sigilo e lealdade para com as hierarquias superiores (desdenhando eventualmente outras formas de conhecimentos especializados exteriores à organização) e isto pode, em certas situações, obscurecer determinados problemas de segurança, com o objetivo de proteger a reputação da organização (esta questão pode ser particularmente visível em organizações militarizadas ou influenciadas por uma cultura militarizada).

Centremo-nos agora nas críticas à teoria dos acidentes normais. Segundo Roberts (1989), não é absolutamente claro que todas as tecnologias de alto-risco irão falhar. Foi também preconizado que as noções de interações complexas e de ligações apertadas são conceitos muito vagos e difíceis de transformar de objeto teórico em objeto empírico, ou seja, a operacionalização destas noções torna-se problemática. Assim, parece difícil conceber um método para a análise ou avaliação de acidentes sistémicos devido a limitações empíricas dos conceitos. Para Weick (1990) os sistemas com ligações soltas e interações lineares não estarão absolutamente imunes a sofrer grandes acidentes, até porque estas condições podem alterar-se – transformando as ligações soltas em ligações apertadas e as interações lineares em interações complexas –, tornando os sistemas mais vulneráveis (tal como aconteceu no desastre aéreo de Tenerife). Esta transformação sistémica pode ocorrer, por exemplo, devido a elevados picos de stress dos trabalhadores, à sobrecarga de trabalho, ao facto de se terem ignorado alguns dados importantes ou a fatores externos extraordinários.24 Alguns críticos de Perrow (Weick, 1990; Hopkins, 1999) afirmam que a teoria dos acidentes normais apenas é relevante e aplicável para os sistemas que apresentem simultaneamente interações muito complexas (high complexity) e ligações apertadas (tight coupling). Um dos preceitos-chave, apresentado por Perrow (1999 [1984]) na teoria dos acidentes normais, está relacionado com o dilema (irresolúvel na sua ótica) que as organizações têm de tentar gerir quando incorporam, simultaneamente, interações complexas e ligações apertadas no seu funcionamento, visto que a primeira característica necessita da uma estrutura organizacional centralizada, e a segunda de uma estrutura organizacional descentralizada. Ou seja, Perrow preconiza que a estrutura das organizações não pode ser centralizada e descentralizada ao mesmo tempo. Weick (1987) critica este pressuposto e afirma que os aspetos culturais das organizações podem conseguir ultrapassar a necessidade de uma estrutura organizacional centralizada no caso de sistemas de funcionamento com ligações apertadas. Outros autores partidários das HRO afirmam que este preceito de Perrow é meramente tautológico. Por fim, é ainda referido que algumas dimensões externas ao sistema (naturalmente mutáveis em determinadas circunstâncias), mas passíveis de influenciar o seu funcionamento, são pouco consideradas pelo autor. Assim, é referido que a teoria do acidente normal deveria passar de uma estrutura estática (centrada no interior do sistema) para uma conceção mais dinâmica, visto que os fatores externos ou ambientais podem influenciar falhas e recombinar novas interações complexas.

Das diversas críticas apontadas à teoria dos acidentes normais poucas são aquelas que nos parecem fazer sentido (exceto, por exemplo, a última referida no parágrafo anterior, em que é destacada a fraca relevância atribuída aos fatores externos). Entendemos, por isso, que este modelo teórico apresenta um forte contributo para a compreensão dos acidentes maiores, independentemente de algumas fragilidades ou limitações que possa revelar. A sua conceção foi sem dúvida um avanço epistemológico para um assunto que ainda revela bastante terreno por desbravar, quer por se tratar de uma temática relativamente recente, quer pelas dificuldades teóricas e empíricas que suscita.

NOTAS FINAIS SOBRE A PREVENÇÃO DE ACIDENTES

As tecnologias complexas incorporam determinadas incertezas mal compreendidas que não conseguimos controlar, nomeadamente as suas interações com o sistema social. Parece que ainda estamos longe de aceitar esta condição. As indefinições dos sistemas sociotécnicos transformam as sociedades atuais em verdadeiros laboratórios experimentais, cujas consequências podem ser imprevisíveis (Beck, 1992). Os riscos organizacionais são, em grande medida, as antecâmaras para os acidentes (Areosa, 2009a; 2009b). Não existem organizações isentas de risco, logo, os acidentes são eventos que podem ocorrer a qualquer momento. Porém, isto não significa que a prevenção não seja útil, mas é pertinente considerar que até a melhor estratégia de prevenção tem os seus limites. Para além disso, tal como referiu Rasmussen (1997), existem diversas condicionantes internas e externas às organizações que podem conduzir a que se ultrapassem as fronteiras de segurança consideradas aceitáveis (naturalmente que este aspeto é sempre algo que implica juízos de valor). É importante referir que as organizações, particularmente as de alto-risco, visam cumprir diversos objetivos (por vezes incompatíveis entre si) e isso torna-as mais vulneráveis a imprevistos na sua atividade. Devemos ainda ter em conta que incorporam muitos outros fatores de risco, de incerteza e de aleatoriedade, aos quais não conseguem escapar. Afinal, o mundo é um local cuja imprevisibilidade é muito maior do que nós, a priori, conseguimos imaginar (Taleb, 2008).

Na perspetiva de Sagan (1993), quer os mentores da teoria dos acidentes normais, quer os teóricos das HRO, recorrem, por vezes, a uma linguagem imprecisa; os primeiros afirmam que os acidentes maiores, apesar de serem eventos raros, são inevitáveis, enquanto os segundos preconizam que existem boas hipóteses de os acidentes poderem ser prevenidos ou que as organizações de alto-risco podem trabalhar num cenário próximo de operações livres de falhas. Todavia, a discussão polarizada entre as duas escolas teve o mérito de consolidar nas ciências sociais o debate sobre os grandes acidentes, dando continuidade ao trabalho iniciado por Turner (1978). Talvez a divergência de fundo entre ambas as perspetivas nos remeta para a resposta à questão primitiva do risco: How safe is safe enough? (Douglas, 1992, p. 41). É verdade que esta é uma pergunta sonante, mas a sua resposta é pouco satisfatória, dado que nunca poderemos afirmar que a segurança é suficientemente segura. A incerteza é algo que caracteriza a modernidade (incluindo as suas organizações), embora, tal como é referido por Granjo (2004), esta condição extravase largamente o atual período em que vivemos, tendo em conta que a incerteza acaba por estar imiscuída em toda história da humanidade; exemplos disto mesmo são os múltiplos sistemas de adivinhação e de previsão do futuro.

A perspetiva das HRO concebe a prevenção de acidentes do seguinte modo: é possível efetuar operações/atividades extremamente seguras, mesmo estando perante tecnologias altamente perigosas, desde que exista um design organizacional apropriado e se sigam determinadas técnicas de gestão inteligentes. A criação de sistemas organizacionais redundantes, a utilização de formas sofisticadas de aprendizagem organizacional, a socialização e treino dos trabalhadores para responder a determinadas situações (controlo centralizado em situações normais e descentralizado em situações de crise), um consenso alargado entre a performance organizacional e os objetivos de segurança, são alguns dos mecanismos mais adequados para a prevenção de acidentes. A produção de uma cultura organizacional que aposte num desempenho livre de falhas, conjugado com a idealização de determinados cenários em que se perceba que os erros podem sempre ocorrer, são também dois aspetos essenciais que, segundo esta perspetiva, permitem consolidar uma estratégia adequada para a prevenção de acidentes. Do ponto de vista teórico, julgamos que os pressupostos das HRO estão bem fundamentados, porém a sua aplicabilidade empírica suscita-nos inúmeras reservas. Entre outros aspetos parece-nos que os mentores das HRO deixam transparecer um otimismo exagerado sobre a forma segura e eficaz de como os indivíduos podem funcionar em contexto organizacional, esquecendo, por exemplo, os inevitáveis conflitos interrelacionais, bem como os interesses pessoais e organizacionais (nem sempre coincidentes).

Segundo Perrow (1999 [1984]), as organizações que possuem sistemas tecnológicos ultra-complexos já provaram que não dispõem de condições para eliminar todos os acidentes. No entanto, isto não significa que estejamos perante organizações incompetentes, ou incapazes de controlar os riscos das suas atividades, significa que a segurança das organizações revela limites inerentes à sua própria condição (Sagan, 1993, p. 279). De certo modo, os acidentes são produzidos socialmente e tornaram-se um acontecimento normal, devido à elevada complexidade de alguns sistemas, às suas interações não-lineares, bem como às suas ligações muito próximas. Isto denota que seria irrealista pensarmos que seria possível prevenir todos os acidentes no contexto das organizações. Toda a teoria de Perrow (1999 [1984]) reforça a ideia de que os acidentes são acontecimentos inevitáveis, e a sua prevenção, em certos contextos, virtualmente impossível de realizar. Mesmo a experiência de acidentes anteriores pouco pode acrescentar à prevenção de futuros acidentes, visto que o alinhamento das suas causas e circunstâncias é normalmente singular e quase irrepetível. Não estando esta apreciação isenta de subjetividade, tendemos a corroborar a perspetiva de Perrow, em detrimento dos alicerces que sustentam as HRO (quanto a nós bastante mais frágeis). Apesar das múltiplas diferenças relatadas ao longo do texto, os dois modelos estimam quase em uníssono que a possibilidade de ocorrer um grande acidente é baixa. Talvez a grande diferença entre estas duas perspetivas se possa resumir ao seguinte: Perrow may look at a glass of safety and find it 1 percent empty; high reliability theorists may see the same glass of safety as 99 percent full (Sagan, 1993, p. 48).

BIBLIOGRAFIA

AREOSA, J. (2005), A hegemonia contemporânea dos novos riscos. In C. Guedes Soares et al. (eds.), Análise e Gestão de Riscos, Segurança e Fiabilidade, Lisboa, Edições Salamandra, pp. 203-218. [ Links ]

AREOSA, J. (2009a), Riscos de uma actividade de risco: um estudo de caso em contexto hospitalar. Configurações, 5/6, pp. 225-239. [ Links ]

AREOSA, J. (2009b), Do risco ao acidente: que possibilidades para a prevenção?. Revista Angolana de Sociologia, 4, pp. 39-65. [ Links ]

AREOSA, J. (2009c), O risco no âmbito da teoria social: quatro perspectivas em debate. Revista Brasileira de Informação Bibliográfica em Ciências Sociais (BIB), 68, pp. 59-76. [ Links ]

AREOSA, J. (2010), O risco nas ciências sociais: uma visão crítica ao paradigma dominante. Revista Angolana de Sociologia, 5/6, pp. 11-33. [ Links ]

AREOSA, J. (2011), Riscos ocupacionais da imagiologia: estudo de caso num hospital português. Tempo Social, 23 (2), pp. 297-318. [ Links ]

AREOSA, J. (2012), As perceções de riscos dos trabalhadores: qual a sua importância para a prevenção de acidentes de trabalho?. In H. Neto, J. Areosa e P. Arezes (eds.), Impacto Social dos Acidentes de Trabalho, Vila do Conde, Civeri Publishing, pp. 65-97. [ Links ]

AREOSA, J. e CARAPINHEIRO, G. (2008), Quando a imagem é profissão: profissões da imagiologia em contexto hospitalar. Sociologia – Problemas e Práticas, 57, pp. 83-108. [ Links ]

AREOSA, J. e DWYER, T. (2010), Acidentes de trabalho: uma abordagem sociológica. Configurações, 7, pp. 107-128. [ Links ]

BECK, U. (1992), Risk Society. Towards a New Modernity, Londres, Sage. [ Links ]

BOIN, A. e SCHULMAN, P. (2008), Assessing NASAs Safety Culture: The limits and possibilities of high-reliability theory. Public Administration Review, 68, pp. 1050-1062. [ Links ]

COHEN, M., MARCH, J. e OLSEN, J. (1972), A garbage can model of organizational choice. Administrative Science Quarterley, 17, pp. 1-25. [ Links ]

DEKKER, S. (2006), Resilience engineering: Chronicling the emergence of confused consensus. In E. Hollnagel, D. Woods e N. Leveson (eds.), Resilience Engineering: Concepts and Precepts, Aldershot, UK, Ashgate Publishing. pp. 77-92. [ Links ]

DOLIVEIRA, T. (2006), Acidentes organizacionais e factores humanos. In J. Gomes, M. Cunha, e A. Rego (orgs.), Comportamento Organizacional e Gestão, Lisboa, Editora RH, pp. 61-76. [ Links ]

DOUGLAS, M. e WILDAVSKY, A. (1982), Risk and Culture: An Essay on the Selection of Technological and Environmental Dangers, Berkeley, CA, University of California Press. [ Links ]

DOUGLAS, M. (1992), Risk and Blame: Essays in Cultural Theory, Londres, Routledge. [ Links ]

DWYER, T. (2000), A produção social do erro – O caso dos acidentes ampliados. In C. Freitas, M. Porto e J. Machado (orgs), Acidentes Industriais Ampliados: Desafios e Perspectivas para o Controle e a Prevenção, Rio de Janeiro, Editora Fiocruz, pp.107-126. [ Links ]

FOSTER, H.D. (1993), Resilience theory and system evaluation. In J.A. Wise, V.D. Hopkin e P. Stager (eds.), Verification and Validation of Complex Systems: Human Factors Issues. Berlim, Springer. [ Links ]

GIDDENS, A. (1998), As Consequências da Modernidade, Oeiras, Celta Editora. [ Links ]

GLADWELL, M. (2008), Outliers, Amadora, Dom Quixote. [ Links ]

GRANJO, P. (2004), Trabalhamos sobre um Barril de Pólvora: Homens e Perigo na Refinaria de Sines, Lisboa, Imprensa de Ciências Sociais. [ Links ]

GRANJO, P. (2006), Quando o conceito de risco se torna perigoso. Análise Social, 181, XLI (4.º), pp. 1167-1179. [ Links ]

HOLLNAGEL, E. (2004), Barriers and Accident Prevention, Hampshire, Ashgate. [ Links ]

HOPKINS, A. (1999), The limits of normal accident theory. Safety Science, 32, pp. 93-102. [ Links ]

JERÓNIMO, H. (2006), A peritagem científica perante o risco e as incertezas. Análise Social, 181, XLI (4.º), pp. 1143-1165. [ Links ]

KASPERSON, R. et al. (2000), The social amplification of risk: A conceptual framework. In P. Slovic, The Perception of Risk, Londres, Earthscan Publications, pp. 232-245. [ Links ]

KEYNES, J. (1921), A Treatise on Probability, Londres, Macmillan. [ Links ]

KNIGHT, F. (1933), Risk, Uncertainty and Profit, Boston, Houghton-Mifflin. [ Links ]

LAPORTE, T. e CONSOLINI, P. (1991), Working in practice but not in theory: Theoretical challenges of high-reliability organizations. Journal of Public Administration Research and Theory, 1, pp. 19-48. [ Links ]

LUPTON, D. (2003), Risk, Londres, Routledge. [ Links ]

MARTINS, H. (1998), Risco, incerteza e escatologia – reflexões sobre o experimentum mundi em curso. Episteme – Revista da Universidade Técnica de Lisboa, 1 e 2, pp. 99-121 e 41-75. [ Links ]

NEMETH, C. (2008), Resilience engineering: the birth of a notion. In E. Hollnagel, C. Nemeth e S. Dekker (eds.), Resilience Engineering Perspectives: Remaining Sensitive to the Possibility of Failure, Aldershot, UK, Ashgate Publishing. [ Links ]

MERTON, R. (1936), The unanticipated consequences of purposive social action. American Sociological Review, 1 (6), pp. 894-904. [ Links ]

PERROW, C. (1991), A society of organizations. Theory and Society, 20, pp. 725-762. [ Links ]

PERROW, C. (1999 [1984]), Normal Accidents: Living with High-Risk Technologies, New Jersey, Princeton University Press. [ Links ]

RASMUSSEN, J. (1994), High reliability organizations, normal accidents, and other dimensions of a risk management problem. Paper – NATO Advanced Research Workshop on Nuclear Arms Safety, Oxford, UK. [ Links ]

RASMUSSEN, J. (1997), Risk management in a dynamic society: A modeling problem. Safety Science, 27, pp. 183-213. [ Links ]

REASON, J. (1990), Human Error, Cambridge, Cambridge University Press. [ Links ]

REASON, J. (1997), Managing the Risks of Organizational Accidents, Aldershot, Ashgate. [ Links ]

REASON, J. e HOBBS, A. (2003), Managing Maintenance Error: A Practical Guide, Hampshire, Ashgate. [ Links ]

RENN, O. (1992), Concepts of risk: a classification. In S. Krimsky e D. Golding (eds.), Social Theories of Risk, Westport, CT, Praeger. [ Links ]

ROBERTS, K. e ROUSSEAU, D. (1989), Research in nearly failure-free, high-reliability organisations: having the bubble. IEEE Transactions of Engineering Management, 2, pp. 132-139. [ Links ]

ROBERTS, K. (1990), Some characteristics of one type of high reliability organization. Organization Science, 1, pp. 160-176. [ Links ]

ROBERTS, K. e BEA, R. (2001), When systems fail. Organisational Dynamics, 3, pp. 179-191. [ Links ]

ROCHLIN, G. (2001), Les organisations à haute fiabilité: bilan et perspectives de recherché. In M. Bourrier, Organizer la Fiabilité, Paris, LHarmattan. [ Links ]

ROSNESS, R. et al. (2000), The vulnerable robustness of high reliability organisations: A case study report from an offshore oil production platform. Paper presented at the 18th ESReDA seminar Risk Management and Human Reliability in Social Context, Karlstad, Sweden.

SAGAN, S. (1993), The Limits of Safety: Organizations, Accidents, and Nuclear Weapons, Princeton, NJ, Princeton University Press. [ Links ]

SAGAN, S. (2004), Learning from normal accidents. Organization & Environment, 17 (1), pp. 15-19. [ Links ]

SCHULMAN, P. (1993), The negotiated order of organizational reliability. Administration & Society, 25, pp. 353-372. [ Links ]

TALEB, N. (2008), O Cisne Negro – O Impacto do Altamente Improvável, Amadora, Dom Quixote. [ Links ]

TURNER, B. (1978), Man Made Disasters, Londres, Wykeham Press. [ Links ]

VAN LOON, J. (2000), Virtual risks in an age of cybernetic reproduction. In B. Adam, U. Beck e J. Van Loon (eds.), The Risk Society and Beyond. Critical Issues for Social Theory, Londres, Sage, pp. 165-182. [ Links ]

VAUGHAN, D. (1996), The Challenger Launch Decision: Risky Technology, Culture and Deviance at NASA, Chicago, University of Chicago Press. [ Links ]

VAUGHAN, D. (1999), The dark side of organizations: Mistake, misconduct, and disaster. Annual Review of Sociology, 25, pp. 271-305. [ Links ]

VIRILIO, P. (1983), Pure War, Nova Iorque, Semiotext(e). [ Links ]

WEBER, M. (1947), The Theory of Social and Economic Organization, Londres, Collier Macmillan Publishers. [ Links ]

WEICK, K. (1987), Organizational culture as a source of high reliability. California Management Review, 29, pp. 112-127. [ Links ]

WEICK, K. (1990), The vulnerable system: An analysis of the Tenerife air disaster. Journal of Management, 16, pp. 571-593. [ Links ]

WEICK, K., STUCLIFFE, K. e OBSTFELD, D. (1999), Organising for high reliability: processes of collective mindfulness. Research in Organisational Behaviour, 21, pp. 81-123. [ Links ]

WEICK, K. e STUCLIFFE, K. (2001), Managing the Unexpected: Assuring High Performance in an Age of Complexity, São Francisco, Jossey-Bass. [ Links ]

WESTRUM, R. (1993), Cultures with requisite imagination. In J.A. Wise, V.D. Hopkin e P. Stager (eds.), Verification and Validation of Complex Systems: Human Factors Issues, Berlim, Springer, pp. 401-416. [ Links ]

WYNNE, B. (1987), Risk Management and Hazardous Waste. Implementation and the Dialectics of Credibility, Berlim, Springer-Verlag. [ Links ]

WYNNE, B. (1988), Unruly technology: Practical rules, impractical discourses and public understanding. Social Studies of Science, 18 (1), pp. 147-167. [ Links ]

WYNNE, B. (1992), Uncertainty and environmental learning: Reconceiving science and policy in the preventive paradigm. Global Environmental Change, 2 (2), pp. 111-127. [ Links ]

Recebido a 13-09-2010. Aceite para publicação a 03-04-2012.

Notas

1 Os sistemas ou organizações resilientes envolvem uma interação entre os diversos componentes do sistema e o seu ambiente circundante (Nemeth, 2008). Regra geral, entende-se por resiliência a capacidade que as organizações detêm para absorver ou incorporar mudanças sem que estas alterações originem efeitos adversos ou falhas catastróficas (Foster, 1993, p. 36). É uma capacidade sistémica de ajustamento funcional que permite enfrentar situações novas, perturbações, pressões ou percalços. A resiliência também pode ser definida como as propriedades intrínsecas de uma organização, suscetíveis de a tornar mais resistente para lidar com certas operações perigosas (Reason e Hobbs, 2003). Isto significa que as organizações podem eventualmente sofrer determinadas pressões ou choques, nomeadamente falhas, distúrbios ou disfunções, sem que estes eventos conduzam necessariamente a acidentes graves ou a efeitos indesejados. Porém, é pertinente referir que esta elasticidade ou flexibilidade (capacidade para voltar à forma original ou para recuperar forças depois de sofrer determinadas pressões) não é infinita, mas pode, no entanto, acomodar determinadas situações sem provocar danos ou perdas, pelo menos até um dado limite.

2 Segundo Rochlin (2001), este grupo foi fundado em Berkeley (Califórnia), inicialmente apenas por três membros (Todd LaPorte, Karlene Roberts e Gene Rochlin), mas rapidamente alargado para um número muito superior de colaboradores. Esta equipa começou por estudar quatro tipos de atividades: controlo de tráfego aéreo, gestão da rede de energia elétrica, centrais nucleares e porta-aviões militares da marinha americana. As organizações que geriam estas atividades/infraestruturas tinham em comum o facto de laborarem em ambientes de alto-risco, mas com bons desempenhos ao nível da segurança.

3 Aliás, a perspetiva teórica das HRO diferencia-se, em parte, de outras perspetivas, que preconizam que as organizações são elas próprias produtoras de erros e acidentes (Turner, 1978; Reason, 1990; 1997; Vaughan, 1996; 1999; Rasmussen, 1997; Perrow, 1999; Dwyer, 2000).

4 No dia 28 de março de 1979 esteve muito perto de ocorrer a fusão da central nuclear TMI, situada na Pensilvânia (Estados Unidos). Os problemas na TMI começaram no polisher (algo similar a um filtro de água de grandes dimensões), o qual aparentemente bloqueou e deixou passar alguma humidade para o sistema de ar da central, que, por sua vez, fez disparar as válvulas que permitiam a entrada de água fria para o sistema de arrefecimento, fechando-as inesperadamente. Sem arrefecimento, o reator nuclear pode aquecer rápida e perigosamente. É para prevenir situações deste tipo que os sistemas complexos como a TMI são desenhados com imensas redundâncias e o sistema de arrefecimento era um desses exemplos. Porém, sem se saber bem porquê, as válvulas do sistema redundante de refrigeração também estavam fechadas. Por coincidência, o mostrador da sala de comando que deveria indicar aos operadores que estas válvulas estavam fechadas encontrava-se naquele dia tapado por um sinalizador de manutenção pendurado no interruptor acima, logo, não se encontrava visível. Contudo, a central TMI ainda dispunha de mais outro mecanismo de segurança, designado por válvula de descarga, mas infelizmente este mecanismo também não funcionou e o seu sinalizador na sala de comando estava avariado. Quando todas estas pequenas falhas foram detetadas o reator da central estava perto de derreter. É importante referir que estes acontecimentos, se tivessem ocorrido isoladamente, seriam considerados eventos quase triviais e sem grande importância para o funcionamento normal da TMI. Todavia, estas pequenas falhas interagiram entre si de forma tão rápida, inesperada e incompreensível que estiveram muito perto de provocar uma catástrofe. Regra geral, os acidentes maiores resultam de interações deste tipo.

5 Embora, não seja frequente os teóricos das HRO dedicarem-se à pesquisa de como e por que motivo as organizações produzem erros. Segundo Rochlin (2001) encontramos apenas duas exceções a este princípio.

6 These organizations share the goal of avoiding altogether serious operational failures. This goal rivals short-term efficiency as a primary operational objective. Indeed, failure-free performance is a condition of providing benefits. The operating challenges are twofold: (1) to manage complex, demanding technologies, making sure to avoid major failures that could cripple, perhaps destroy, the organization; at the same time, (2) to maintain the capacity for meeting periods of very high, peak demand and production whenever these occur (LaPorte e Consolini, 1991, p. 21).

7 Segundo Rosness et al. (2000), a redundância organizacional refere-se a padrões de cooperação que permitem à organização (no seu todo) obter níveis de desempenho mais fiáveis, comparativamente com as suas partes, vistas individualmente.

8 Uma das exceções a esta regra pode ser encontrada na comunicação entre pilotos e controladores aéreos, devido à necessidade de prevenir eventuais interpretações dúbias durante o processo comunicativo (troca de informação). Porém, um exemplo de como a comunicação entre pilotos e controladores de tráfego aéreo falhou redondamente ficou patente no desastre do voo 52 Avianca. Neste caso, o avião despenhou-se por falta de combustível, depois de permanecer nas imediações do aeroporto durante mais de uma hora a aguardar autorização para aterrar (Gladwell, 2008).

9 O conhecimento especializado de alguns trabalhadores (experts) é por vezes confrontado com a diferença entre o trabalho prescrito (como ele deve ser efetuado) e o trabalho real (como ele é executado na prática). Esta questão remete-nos para o facto de que não existe nenhuma organização onde não exista trabalho informal – podemos verificar esta situação, por exemplo, em contexto hospitalar (cf. Areosa e Carapinheiro, 2008) – e isto pode ser um fator contraditório com os princípios das HRO. Seen from the outside, a defining characteristic of such informal work systems would be routine violations of procedures (which, in aviation, is commonly thought to be unsafe). But from the inside, the same behaviour is a mark of expertise, fuelled by professional and interpeer pride. And of course, informal work systems emerge and thrive in the first place because procedures are inadequate to cope with local challenges and surprises, and because procedures (and managements) conception of work collides with the scarcity, pressure and multiple goals of real work (Dekker, 2006, p. 86).

10 A título de exemplo, Martins (1998) defende que o mundo contemporâneo poderia ser apelidado de sociedades de incerteza ou sociedades aleatórias, por oposição ao termo sociedades de risco preconizado por Beck (1992). O risco e a incerteza são, por vezes, tomados como sinónimos (embora, do nosso ponto de vista, erradamente), visto que os dois conceitos resultam de uma ausência de garantias absolutas acerca do futuro. É verdade que ambas as noções estão muito ligadas, pois não existe risco sem incerteza (Van Loon, 2000, p. 166). A incerteza é vista como uma forma de conhecimento incompleto, insuficiente ou inexistente. Parece também aproximar-se a situações aleatórias, ambíguas e indeterminadas ou, como refere Wynne (1992), pode significar ignorância. A incerteza é suscetível de provocar dúvidas e desconfiança, dado que se afasta da ideia de segurança e isso torna-a, normalmente, inquietante. Diversos autores (Keynes, 1921; Knigth, 1933; Lupton, 2003) distinguem conceptualmente o risco da incerteza, afirmando que apenas ao primeiro é possível indexar probabilidades. Helena Jerónimo (2006, p. 1156) preconiza que a ideia de risco está tendencialmente associada à prevenção, enquanto a incerteza está mais próxima da precaução. Isto porque, acrescenta a autora, o risco é passível de mitigação, negociação e aceitação, mas a incerteza (no sentido de ignorância e indeterminação – ambos os aspetos designados por Wynne (1987) como riscos de segunda ordem) remete-nos para a prudência.

11 Um resumo das principais características das HRO pode também ser encontrado na obra de Sagan: High reliability theorists believe that hazardous technologies can be safely controlled by complex organizations if wise design and management techniques are followed. This optimistic conclusion is based on the argument that effective organizations can meet the following four specific conditions, which are necessary to create and maintain adequate safety: 1 – political elites and organization leaders place a high priority on safety and reliability; 2 – significant levels of redundancy exist, permitting backup or overlapping units to compensate for failures; 3 – error rates are reduced through decentralization of authority, strong organizational culture, and continuous operations and training; and 4 – organizational learning takes place through a trial-and-error process, supplemented by anticipation and simulation. These conditions have been witnessed in a number of high reliability organizations, and if these conditions exist in other organizations, then the theory would predict that serious accidents and catastrophes can be prevented (Sagan, 1993, p. 27).

12 Poderemos traduzir este conceito como algo que requer atenção ou cuidado.

13 No entanto, é pertinente ter em conta que até mesmo os melhores trabalhadores podem cometer os piores erros, visto que, por exemplo, as perceções de riscos podem formular julgamentos enviesados sobre a realidade organizacional (Areosa, 2009a, 2011 e 2012).

14 O autor considera ambas as noções como sinónimas.

15 As interações complexas (não lineares) podem ser definidas como sequências de eventos invulgares, não planeados e imprevistos. Na maioria das vezes as interações complexas podem não ser imediatamente visíveis dentro da organização (Perrow, 1999, p. 78).

16 Sagan (1993) sugere que a perspetiva de Perrow sobre os acidentes normais pode ter sido influenciada por um modelo designado por garbage can model (Cohen, March, Olsen, 1972). Este modelo pode ser incluído no âmbito das teorias comportamentais organizacionais e nas teorias das decisões organizacionais. Um dos seus principais preceitos preconiza que algumas organizações são entidades anarquicamente organizadas. Paralelamente Hollnagel (2004) considera que o modelo sistémico dos acidentes pode ter tido as suas origens nas teorias do controlo ou mesmo nas famosas teorias do caos da autoria de Lorenz.

17 Estima-se que apenas ¼ dos futuros acidentes seriam possíveis de prevenir, caso se recorresse à experiência e ao conhecimento obtidos através da investigação de acidentes anteriores (cf. Granjo, 2006). Contudo, esta estimativa está longe de ser consensual entre os especialistas desta temática.

18 Porém, outros autores preconizam que os acidentes maiores e os acidentes menores podem ter mais semelhanças do que aquilo que seria expectável à primeira vista (Areosa e Dwyer, 2010).

19 Segundo Perrow (1999, p. 70) os sistemas podem ser divididos em quatro níveis: unidades, partes, subsistemas e sistema.

20 No estudo de Granjo (2006) sobre a refinaria de Sines é relatada a eletrocussão de um gato, num posto de transformação, do qual resultou um curto-circuito e a consequente quebra de energia em toda a fábrica. Este evento inesperado deu origem quer a elevados prejuízos económicos (devido à paragem da laboração), quer a dois quase-acidentes que se seguiram, apenas travados nos últimos instantes.

21 Compared to the high reliability approach, the normal accidents theory is both more structural and more political. It is more structural because Perrow identifies two specific structural characteristics of many organizations operating dangerous technologies – interactive complexity and tight-coupling – which make them highly accident prone regardless of the intent of their leaders or operators. The theory is also more political because it focuses attention on the interaction of conflicting interests both within these organizations and between the organizations and the broader political community. Such conflicting interests can exert a strong influence on the frequency of catastrophic accidents, on their interpretation and therefore who receives the blame for failures, and, finally, on the degree to which the organizational structures that make normal accidents inevitable are modified or abandoned (Sagan, 1993, p. 32).

22 Segundo Roberts (1990) dentro do conjunto das organizações consideradas perigosas existe um subconjunto que apresenta bons registos nos seus níveis de segurança, durante longos períodos de tempo. Esta será uma das características que permite distinguir as HRO das outras organizações. Na perspetiva da autora poderemos identificar o subconjunto das HRO respondendo à seguinte questão: How many times could this organization have failed resulting in catastrophic consequences that it did not? If the answer is on the order of tens of thousands of times the organization is high reliability (Roberts, 1990, p. 160). Um exemplo contraditório sobre quais as organizações que devem ser consideradas HRO pode ser encontrado na literatura; no final dos anos 80, Roberts e Rousseau (1989) consideravam a NASA como uma HRO. No entanto, alguns anos depois, Roberts e Bea (2001) e Boin e Schulman (2008) vieram afirmar que a NASA não exibia as características de uma HRO.

23 Neste caso o autor fala na interação entre a falta de visibilidade e as falhas na comunicação como as principais explicações (fatores de risco) para o desastre de Tenerife. Outros desenvolvimentos sobre a noção de risco podem ser encontrados nos trabalhos de Beck (1992), Renn (1992), Martins (1998), Granjo (2004; 2006) e Areosa (2005; 2009b; 2009c; 2010).

24 The point of these details is that normal accidents may not be confined to obvious sites of technical complexity such as nuclear power plants. Instead, they may occur in any system that is capable of changing from loose to tight and from linear to complex. As we have suggested, any system, no matter how loose and linear it may seem, can become tighter and more complex when it is subjected to overload, misperception, regression, and individualized response (Weick, 1990, p. 587).