1. Introdução

As expressões faciais, reflexos dos estados de ânimo, desempenham um papel crucial no processo de aprendizagem. Reconhecê-las implica diretamente no contexto educacional, pois refletem na forma como os alunos se apropriam e compreendem novas informações (Longui, 2011).

O estado de ânimo pode afetar a motivação, a participação e o desempenho dos estudantes. Reconhecê-lo, pode favorecer a adaptação de conteúdos e práticas pedagógicas, pelos docentes, aumentando as chances de engajamento dos alunos (Perassinoto, et al, 2013); (Fonseca, 2016). Logo, a personalização da educação depende da capacidade de rastrear e identificar o comportamento do aluno, de modo a orientar o processo de aprendizagem. Uma abordagem assim, considera as particularidades de cada aluno, como interesses, conhecimentos prévios e ritmo de aprendizagem, permitindo que o ensino seja adaptado às suas necessidades (Tomás, 2021).

Nesse contexto, as tecnologias digitais utilizadas como apoio as práticas pedagógicas, permitem ao estudante criar coisas novas, compartilhar suas experiências e aprender em qualquer lugar. A afetividade aliada a intencionalidade e o planejamento, pode construir com uma comunicação mais efetiva e acolhedora entre professores e alunos (Moran, 2021).

Um exemplo de tecnologia que pode auxiliar na personalização dos processos educacionais é a visão computacional. Por meio de algoritmos e técnicas de processamento de imagens, essa tecnologia permite que os sistemas coletem informações e compreendam o conteúdo visual de expressões e vídeos (Backes & Junior, 2019).

A visão computacional pode ser definida como uma área da inteligência artificial, que capacita os computadores a explicar e compreender o mundo visual, assim como os seres humanos. Suas aplicações são diversas e incluem o reconhecimento facial, diagnóstico de doenças e identificação e geolocalização automática de potenciais criadouros do mosquito e pragas em plantações, vigilância inteligente, identificação de defeitos em pavimentos asfálticos e veículos autônomos. Essa tecnologia demonstra um grande potencial para contribuir com avanços em diversas áreas (Barelli, 2018); (Gonçalves, et al, 2023); (Lima, et al, 2021).

Frente ao exposto, a presente pesquisa visa apresentar os resultados do desenvolvimento de uma ferramenta de reconhecimento de expressões básicas dos estudantes, por meio da visão computacional. A sua importância provém da consideração que as emoções básicas, podem ser identificadas através do comportamento, da ativação corporal e da expressão facial, sendo elas: alegria, nojo, raiva, surpresa, tristeza e medo (Possebon, 2017). A funcionalidade foi implementada em um editor de texto coletivo assíncrono, denominado Editor de Texto Coletivo (ETC). O objetivo é coletar os dados sobre as expressões faciais dos estudantes durante a produção textual para apoiar práticas pedagógicas a fim de aumentar o engajamento dos alunos. Desse modo, o professor pode observar os aspectos afetivos relacionados ao estudante, durante a produção textual, e a partir destas informações construir estratégias personalizadas, que apoiem o processo de ensino e aprendizagem.

O presente artigo está dividido em: fundamentação teórica descrita na seção 2, seguida pela metodologia na seção 3, que aborda os métodos e ferramentas escolhidas para desenvolvimento da aplicação. A seção 4 apresenta os resultados e discussões obtidos da construção da ferramenta e, ao final, a apresentação das conclusões.

2.Fundamentação Teórica

Esta seção apresenta o ETC, ambiente no qual foi implementado o sistema de reconhecimento de expressões básicas. Além disso, aborda o estudo das microexpressões faciais, tema fundamental para o desenvolvimento da ferramenta, visto que é com base neste estudo que as principais bibliotecas de reconhecimento de expressão se baseiam.

2.1. Editor de Texto Coletivo

As tecnologias desenvolvidas no contexto educacional podem auxiliar os alunos em suas atividades didáticas, bem como desempenham um papel fundamental na geração de informações para docentes e tutores (Pereira, et al, 2019)

Nesse contexto, o Editor de Texto Coletivo (ETC) surge como uma ferramenta que favorece a colaboração e organização coletiva e interativa na estrutura do texto entre estudantes durante a produção textual (Behar, et al, 2004). O Editor é uma plataforma de livre acesso desenvolvida pelo Núcleo de Tecnologia Digital Aplicada à Educação (NUTED) e está disponível em: http://nuted.edu.ufrgs.br/etc/.

O ETC apresenta recursos como chat e fórum de discussão que permitem elaborações coletivas. Também apresenta a biblioteca virtual onde podem ser cadastrados livros, artigos e documentos acadêmicos para apoio à escrita. Em paralelo, o editor oferece ferramentas de acompanhamento da produção, permitindo aos usuários identificar oportunidades de melhoria. Dentre as disponíveis estão o RecETC (Recomendado de Conteúdos) para recomendação de artigos, imagens e vídeos selecionados a partir da mineração das palavras-chave do texto e a RedETC (Rede de Conceitos) que exibe um grafo relacionando os conceitos-chave do texto com a respectiva autoria dos termos. A Figura 1 apresenta a tela de edição de um texto no ETC.

Pelas características dos recursos e suas intencionalidades, destaca-se que o ETC tem maior importância e foco no desenvolvimento de pesquisas acadêmicas relacionadas às tecnologias aplicadas na educação.

2.2. Estudo das Microexpressões Faciais

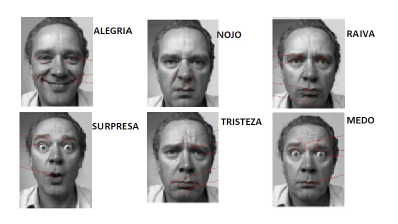

O estudo das microexpressões faciais ficou amplamente reconhecido após a publicação do livro "Facial Action Coding System: A Technique for the Measurement of Facial Movement" (FACS) em 1978, escrito pelo psicólogo Paul Ekman e o biógrafo Wallace Freisen. Neste trabalho, os pesquisadores identificaram as Action Units (AU), que são movimentos musculares faciais que envolvem a contração ou relaxamento visível de um, ou vários músculos da face humana. Essas AU’s são utilizadas para determinar a expressão facial de um indivíduo (Ekman & Freisen, 1978). Assim, Ekman e Freisen (1978) definiram 6 (seis) expressões básicas universais: alegria, nojo, raiva, surpresa, tristeza, e medo, presentes na Figura 2.

Essas expressões, segundo os autores, são universalmente reconhecidas por pessoas de diversas partes do mundo, mesmo sem palavras e independentemente das diferenças culturais. O motivo são as repetições de padrões de contração na musculatura da face ou as chamadas AU’s. Logo, para cada expressão, pode-se atribuir características universais:

Alegria: há presença de um sorriso com estiramento dos lábios e os dentes expostos. Além disso, a distância entre a boca e o nariz diminui à medida que o sorriso se intensifica. As bochechas se elevam e os olhos podem apresentar um leve estreitamento, acompanhado de rugas ao redor deles.

Nojo: durante essa expressão, o lábio superior se eleva expondo os dentes superiores e criando uma expressão de repulsa. Ao mesmo tempo, o nariz se enruga, formando linhas verticais nasais. Essa combinação de elevação do lábio superior e enrugamento nasal é considerada uma característica distinta da expressão de nojo. Além disso, pode haver um ligeiro afastamento dos olhos e uma expressão facial geral de desconforto ou aversão.

Raiva: as sobrancelhas são franzidas e puxadas para baixo formando uma linha reta ou inclinada. Os olhos podem se estreitar e fixar o alvo com um olhar intenso. A testa pode enrugar e a região em torno do nariz pode se contrair. Os lábios tendem a se pressionar firmemente e podem ficar tensos ou retos, sem curvatura ou sorriso. Pode haver também um aperto da mandíbula e tensão visível no rosto.

Surpresa: as sobrancelhas se levantam rapidamente, formando uma curva arqueada. Os olhos se abrem amplamente com as pálpebras superiores elevadas e as sobrancelhas levantadas. A boca também se abre, muitas vezes com os lábios levemente separados. A testa pode enrugar momentaneamente devido ao levantamento repentino das sobrancelhas. Essa expressão facial de surpresa é caracterizada pela elevação das sobrancelhas, abertura dos olhos e abertura da boca, transmitindo a sensação de espanto ou choque.

Tristeza: as sobrancelhas se abaixam, formando uma linha reta ou inclinada para baixo. Os cantos da boca se voltam para baixo, criando uma curva descendente nos lábios. Os olhos podem se encher de lágrimas ou ficar úmidos e pode haver um ligeiro afastamento das pálpebras superiores. Além disso, pode ocorrer uma leve contração dos músculos ao redor dos olhos, formando rugas.

Medo: durante essa expressão as sobrancelhas se levantam e se juntam, formando linhas horizontais na testa. Os olhos se abrem amplamente com as pálpebras superiores levantadas e as sobrancelhas arqueadas. A boca também pode se abrir, com os lábios esticados e os cantos voltados para trás. Além disso, a pele ao redor dos olhos pode enrugar e a parte inferior do rosto pode se retrair ligeiramente.

Tais expressões são relevantes para o contexto dessa pesquisa, uma vez que se enquadram como uma importante ferramenta de análise de emoções, pois são responsáveis por afetar diretamente o processo cognitivo do aluno (Longui, 2011).

3.Metodologia

Para otimizar a execução desta pesquisa, a metodologia foi baseada em dois autores (Dresch, et al, 2020) e (Beck, 2000). O primeiro, tem por objetivo facilitar o embasamento teórico e escolha das tecnologias que serão utilizadas durante a criação da ferramenta. O segundo tem como principal proposta implementar o método Expreme Programming (XP), com ênfase no desenvolvimento iterativo e incremental, onde o processo é realizado mediante interações curtas e em cada interação o software é desenvolvido, testado e entregue. A metodologia Extreme Programming (XP) foi desenvolvida por Kent Beck no final da década de 1990 e é uma abordagem ágil para o desenvolvimento de software.

A partir do exposto, dividiu-se a metodologia em quatro etapas: (i) desenvolvimento da base teórica, (ii) seleção das ferramentas e bibliotecas, (iii) desenvolvimento das funcionalidades e integração no Editor de Texto Coletivo (ETC), (iv) realização de testes com especialista e análise dos resultados.

Na etapa 1 desenvolveu-se a Revisão Sistemática de Literatura (RSL), para realizar uma busca aprofundada sobre conceitos do estudo. O método de RSL foi dividido em cinco principais itens: definição do tema central; estratégia de busca; critérios de seleção; avaliação da qualidade, relevância e síntese dos resultados; e apresentação dos estudos. Com base nessa investigação, foi possível escolher as ferramentas e bibliotecas utilizadas para o desenvolvimento da funcionalidade (etapa 2), tendo como critério principal a disponibilidade gratuita e a portabilidade com ambientes de Web.

Na etapa 3 foram previstas a construção da ferramenta e a sua incorporação no ETC. A funcionalidade tem como objetivo reconhecer as expressões faciais, segundo a teoria de Ekman e Wallace (1978), durante a produção textual no Editor de Texto Coletivo. Neste sentido, por meio da webcam, o algoritmo captura as imagens e as classifica durante uma unidade de tempo. Os dados coletados são armazenados e podem ser consultados por todos os autores na forma de um gráfico.

Depois disso, se iniciou a etapa de testes (4). O objetivo foi verificar se a ferramenta apresenta bons resultados em termos de desempenho, usabilidade e segurança. A etapa 4 contou com a participação de um especialista e os dados foram coletados por meio de um formulário eletrônico composto por perguntas objetivas e subjetivas.

4.Resultados e discussões

Nesta secção são apresentados e discutidos os resultados de cada etapa da pesquisa.

4.1. Desenvolvimento da base teórica

Esta seção apresenta os métodos e resultados encontrados na Revisão Sistemática de Literatura (RSL), com o propósito de encontrar e analisar as pesquisas recentes relacionadas aos aspectos afetivos que as API’s (Application Programming Interface) utilizam para o reconhecimento de feições por meio da visão computacional.

A estruturação desta RSL foi dividida em cinco etapas, apresentadas a seguir (Dresch, et al, 2020).

Definição do tema central - Definiu-se a pergunta norteadora da pesquisa desenvolvida, sendo ela: “Quais aspectos afetivos que as principais API’s utilizam? ”. Também é recomendado utilizar-se de perguntas adicionais para complementação da pesquisa e clareza no entendimento dos tópicos abordados. Desse modo, na sequência, encontram-se as perguntas também utilizadas como base nessa revisão bibliográfica: a) Quais são as classificações utilizadas pelas API’s (Interface de Programação de Aplicação) na análise de feição do usuário?; b) Qual a linguagem de programação mais utilizada para reconhecimento facial?; c) Quais os pontos fracos e fortes de cada aplicação encontrada?

Estratégias de busca - Para a busca utilizaram-se sites de busca dos seguintes periódicos: Capes, IEEE, Scielo, Elsevier e Google Acadêmico. Além disso, foram consultadas as seguintes revistas de tecnologia: Renote, Revista Ibero-Americana de Educação e Revista Brasileira de Educação. As palavras-chave da pesquisa foram: “Visão computacional, API’s e Aspectos Afetivos/Afetividade”. Assim, os termos de pesquisa utilizados foram: "visão computacional" E "reconhecimento de emoções" OU "computação afetiva"; "Computer vision" AND "Emotion Recognition" OR "affective computing”.

Critérios de seleção - A pesquisa retornou aproximadamente 27 (vinte e sete) artigos. Contudo, depois da aplicação dos critérios de inclusão e exclusão, obteve-se como resultado de 7 (sete) artigos para análise. Os artigos analisados estão descritos na Tabela 1.

Tabela 1 Síntese dos Resultados

| Autores | Expressões | Biblioteca | Banco de dados | Linguagem de programação | Considerações dos autores |

|---|---|---|---|---|---|

| Scardua et. al, 2019. | Alegria, tristeza, raiva, medo, repulsa (nojo) e surpresa (espanto) | Open CV | Não informado | Python | Procedimentos estéticos podem dificultar o reconhecimento. |

| Neto et. Al, 2019. | Alegria, tristeza, raiva, medo, repulsa (nojo) e surpresa (espanto), neutro | Open CV | Compoud Facial Expressions of Emotion Database | Python | Maior acerto em emoções como: repulsa, felicidade e medo. |

| Behling, Alexandre. 2019. | Desgosto, Felicidade, Medo, Neutro, Raiva, Surpresa, Tédio, Tristeza | Open CV | Open Face | Python | Média de 66% de acerto nas emoções. |

| Ferreira, Michael. 2021. | Alegria, Nojo, Medo, Feliz, Triste, Surpresa, Neutro. | Open CV | FER2013 | Python | Média de 60% de acerto nas emoções. |

| Aranha, Renan. 2022 | Alegria, Nojo, Medo, Feliz, Triste, Surpresa, Neutro. | Face-API | Microsoft | JavaScript | Não faz considerações relevantes API. |

| Mendonça, Thomas. 2018. | Desgosto, Surpresa, Felicidade, Tristeza e Medo. | Open CV | JAFFE | Python | Média de 62% de acerto nas emoções. |

| Guedes et. Al, 2022. | Alegria, Nojo, Medo, Feliz, Triste, Surpresa, Neutro. | Face-API | Microsoft | JavaScript | Acurácia entre 60% e 90%. |

Avaliação da qualidade, relevância e síntese dos resultados - Nesta etapa da revisão sistemática realizou-se o estudo dos artigos selecionados. A partir deles, foi possível encontrar informações relevantes para o presente estudo, considerando a plataforma de programação, os aspectos afetivos analisados, a ferramenta de análise utilizada para inferir as feições, o banco de dados ou datasheet e a linguagem de programação padrão utilizada para a aplicação. A partir dessa última etapa foram selecionadas as informações dos artigos estudados, como: expressões identificadas por cada autor, ferramenta de análise das expressões, plataforma padrão de desenvolvimento, banco de imagens ou modelos, linguagem de programação utilizada e os principais resultados obtidos por cada publicação. Os dados foram norteadores para as escolhas das ferramentas e procedimentos utilizados no desenvolvimento desta pesquisa.

Apresentação dos estudos - Com base nos estudos apresentados, pode-se observar diferentes técnicas e procedimentos utilizados para detecção de feições por visão computacional. Os artigos utilizados na pesquisa apresentaram resultados de acurácia e/ou considerações relevantes acerca da API e do banco de dados utilizado nos procedimentos que costumam variar de 60% a 90% de exatidão. As pesquisas demonstram que as API’s apresentam acurácia semelhante e se faz necessário ficar atento a modificações faciais nos usuários. Apesar de cada biblioteca ter portabilidade para diferentes linguagens de programação, é mais comum que aplicações deste tipo sejam realizadas em Python e JavaScript.

4.2. Seleção das ferramentas e bibliotecas

Nesta pesquisa optou-se pelo uso da plataforma Visual Studio Code para desenvolvimento das atividades propostas. A escolha foi motivada por sua facilidade de implementação com ambiente Web e disponibilidade do banco de modelos da Face-API, além de ser gratuito e apresentar resultados satisfatórios nas pesquisas analisadas.

A Revisão Sistemática da Literatura também proporcionou o conhecimento das ferramentas de análise das expressões faciais. Assim, foi possível observar que as principais bibliotecas de identificação de expressões reconhecem as seguintes emoções: alegria, tristeza, raiva, medo, nojo, surpresa e neutralidade.

Nesta etapa, observou-se que diferentes bancos de imagens podem ser aplicados para realização desta tarefa, podendo utilizar modelos pré-treinados por inteligência artificial ou treinando um modelo próprio. Nesta pesquisa, optou-se por utilizar modelos já treinados devido a sua acurácia e por se tratar de uma aplicação com usuários e cenários diferentes daqueles apresentados pelos estudos. Com base na análise, pode-se compreender, também, os cenários que dificultam a identificação da expressão facial, como: rostos com a presença de óculos, pelos faciais, tatuagens e procedimentos estéticos.

A escolha das ferramentas e bibliotecas utilizadas no desenvolvimento apoiou-se no levantamento de dados da Revisão Sistemática de Literatura. A partir dela, optou-se por escolher a biblioteca FaceAPI, disponibilizada pela MicrosoftAzure. O motivo da escolha foram os bons resultados apresentados segundo as pesquisas, a gratuidade e a compatibilidade com ambientes de web.

É importante ressaltar que a biblioteca utilizada já apresenta funções de reconhecimento de expressões faciais e detecção facial treinados com modelos disponibilizados pela própria. Por conta disso, não se realizou o treinamento de uma ferramenta para o desenvolvimento dessa aplicação.

A plataforma de desenvolvimento utilizada foi a Visual Studio Code, desenvolvida pela Microsoft. A linguagem de programação escolhida foi JavaScript por permitir a manipulação da biblioteca FaceAPI, assim como a criação de gráficos que serão utilizados para a amostragem dos relatórios de expressões de cada aluno.

Para teste do servidor, utilizou-se a plataforma Xampp, ela permite que o usuário manipule e crie seu próprio servidor facilitando o processo de testes da aplicação.

Em relação ao desenvolvimento da funcionalidade e aplicação no Editor de Texto Coletivo, destaca-se que o código-fonte do ETC foi disponibilizado pela equipe do NUTED. Desse modo, a partir deste código, foi inserida a funcionalidade desenvolvida neste projeto.

4.3 Desenvolvimento das funcionalidades e integração no Editor de Texto Coletivo (ETC)

Nesta fase, utilizou-se a biblioteca FaceAPI em conjunto com a linguagem de programação JavaScript. Nesta biblioteca há a presença de um banco de modelos de faces e expressões disponibilizados gratuitamente pela Microsoft.

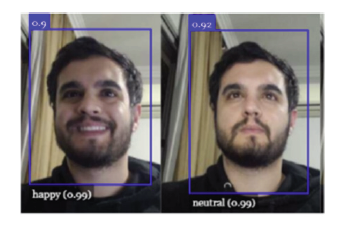

O algoritmo identifica e cria uma caixa delimitadora (bound-box) ao redor da face do usuário quando a webcam é acionada, retornando sua expressão em tempo real. O resultado numérico é apresentado em formato de porcentagem, sendo, basicamente, a correlação dos traços da expressão do usuário com as expressões do banco de modelos. Logo, o programa pode retornar mais de uma expressão, porém com valores diferentes de correlação. O resultado desse processo está na Figura 3.

Com base na Figura 3, pode-se observar que a biblioteca retorna dois tipos de valores. Na parte superior do retângulo em azul tem-se a probabilidade de existir uma face na bound-box. Além disso, o valor apresentado na cor branca na parte inferior do quadro, representa o resultado em percentual da emoção capturada naquele momento, em comparação com as expressões do banco.

A ferramenta retorna sete tipos de expressões: alegria, nojo, raiva, surpresa, tristeza, medo e neutralidade (ausência das demais expressões). Assim, para implementar essa aplicação em uma página da web, foi necessário a integração desse algoritmo com outro programa na linguagem HTML, sendo este, responsável por definir a estrutura e formatação da tela do usuário. Além disso, foi desenvolvido um algoritmo para receber o código de identificação do texto e o nome do usuário.

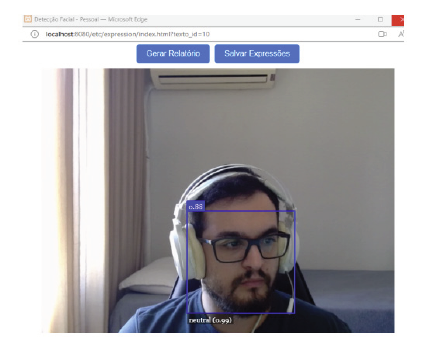

A tela gerada por essa etapa é apresentada na Figura 4. Os dois botões funcionam respectivamente para: Gerar Relatório e Salvar Expressões. O primeiro tem a função de abrir uma página de relatório e o segundo tem a função de armazenar as informações no banco de dados manualmente.

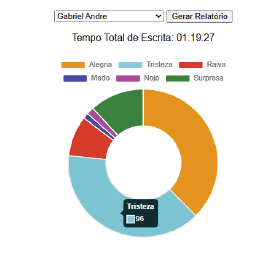

O armazenamento das informações geradas pela captação das expressões faciais do usuário é realizado a partir de uma matriz que contabiliza as ocorrências das expressões. O algoritmo atualiza a expressão com a maior correlação a cada segundo, incrementando o valor correspondente na matriz. Durante esta etapa, a expressão de “neutralidade” foi excluída devido à alta incidência durante a produção textual, prejudicando a análise do gráfico da Figura 5. Para a geração do relatório foi criada uma tabela no banco de dados do ETC usando MySQL. Ela armazena as expressões, um identificador de texto chamado de “Id_text”, o tempo total de escrita do usuário em milissegundos e o nome do usuário que está utilizando a plataforma.

O envio dessas informações ao banco de dados foi desenvolvido em JavaScript e utiliza o método assíncrono Ajax para se comunicar com um sub-programa implementado em PHP. Este último é responsável por receber as informações e encaminhá-las para o banco de dados por meio do servidor principal. O sistema grava os dados no banco quando: i) O usuário clica no botão “Salvar Expressões” na janela principal da aplicação (Figura 4); ii) O usuário pressiona o botão “Gerar Relatório” na janela principal da aplicação (Figura 4) ou iii) O usuário salva o documento de texto utilizando o botão disquete do ETC (Figura 1).

Desse modo, é possível assegurar que o usuário não perca suas informações durante o processo de escrita, uma vez que o ETC não salva automaticamente o documento. Além disso, para prevenir que o usuário encerre a aplicação sem salvar, foi desenvolvido um pop-up de alerta que notifica quando os dados não foram salvos antes do fechamento da janela.

A página de relatório de expressões pode ser observada na Figura 5. O código desta página combina as linguagens de programação HTML e JavaScript. Assim, os usuários conseguem visualizar informações detalhadas de todas as pessoas que contribuíram para a produção do texto.

A funcionalidade relatório conta com uma barra de seleção que permite ao usuário escolher o autor do texto que deseja analisar. Após realizar a seleção, deve-se pressionar o botão “Gerar Relatório”. Na tela é mostrado um gráfico em formato de rosca que apresenta a quantidade de ocorrências das expressões faciais. A biblioteca utilizada para criação do gráfico foi a “Charts.Js”, ela é livre e tem compatibilidade com o JavaScript. O respectivo número de expressões do gráfico surge na tela e é informado quando o usuário aproxima o cursor do mouse na região de interesse, assim como retrata a Figura 5.

Além do gráfico, nesta página também há a informação da quantidade de tempo que cada usuário contribuiu para a produção textual, essa informação ajuda os docentes na análise do engajamento do aluno.

A página visa garantir a melhor experiência e facilidade para o usuário. No gráfico há a presença de legendas relacionadas a cada expressão. As cores das expressões apresentadas no foram baseadas no modelo de representação dos estados de ânimo proposto pela pesquisadora Longhi (Longhi, 2011).

Essa página visa fornecer dados sobre as expressões dos alunos enquanto utilizam a ferramenta, destacando-as como a principal manifestação das emoções que, consequentemente, podem impactar no processo de aprendizagem (Longhi, 2011).

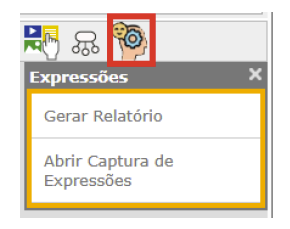

Um ícone foi incorporado à barra de ferramentas do ETC, conforme ilustrado em vermelho na Figura 6. Dessa forma, caso o usuário opte por não autorizar inicialmente a captura de dados de expressão facial, ele pode iniciar a aplicação em outro momento ou consultar os dados já armazenados sobre aquele documento. Além disso, se o usuário fechar a aplicação e desejar reabri-la, ele pode recorrer ao ícone da funcionalidade na barra de ferramentas da tela principal do ETC.

O ícone permite ao usuário abrir a página de relatório e a janela de captura de expressões expostas na Figura 4 e 5, respectivamente.

Além da implementação dos botões, foi criada uma mensagem de aviso, com propósito de assegurar que o autor do texto autorize a coleta de dados relacionados às expressões faciais. Assim, em situações em que essa autorização é concedida, o sistema procede com a execução do programa principal, contudo, caso a autorização seja negada, a página não será aberta. Além disso, foram desenvolvidos dois cookies para o armazenamento de informações, cada um com funções específicas:

O primeiro cookie tem a finalidade de prevenir que duas janelas sejam abertas e executadas ao mesmo tempo, garantindo consistência nos dados armazenados no banco.

O segundo cookie assegura que o usuário confirme sua permissão de coleta de dados somente uma vez em um intervalo de 24 horas, promovendo controle adequado sobre a coleta de informações sensíveis.

4.4 Testes com especialista e análise dos resultados

Com a funcionalidade completa, foram conduzidos testes em colaboração com um especialista. O tempo de avaliação foi de 2 horas e, ao término do uso, aplicou-se um formulário para analisar os seguintes critérios: usabilidade, aspecto visual, tempo de resposta (desempenho), segurança, experiência durante o uso, ocorrências de erros e retorno (feedback) da ferramenta. A avaliação dos pontos ocorreu por meio dos seguintes métodos: atribuição de pontuações em uma faixa de valores de 1 a 5 (muito ruim, ruim, médio, bom e excelente) e questões dissertativas.

O especialista atribuiu os valores de pontuação 4 (bom) para os critérios de usabilidade, aspectos visual e experiência. Os critérios de tempo de resposta e segurança receberam a pontuação máxima (muito bom), e também relatou que não houve ocorrência de erros durante o uso da aplicação.

No entanto, relatou que houve confusão em relação ao processo de salvar as expressões, o que destaca a importância do botão “Salvar Expressões” da Figura 4. Por este motivo, antes de ser implementado em definitivo, esse ícone será retirado e a aplicação contará apenas com as opções de armazenamento automático das expressões (quando o usuário abrir a página de relatórios e ao salvar o texto).

Além disso, houve dúvida quanto ao processo de geração de relatório. Segundo o especialista, o botão “Gerar Relatório” da Figura 4, poderia ser descartado e essa funcionalidade ser implementada somente pelo ícone da Figura 6. Essa modificação será discutida e avaliada com o grupo de pesquisa.

A partir dos testes com um especialista, pode-se concluir que a funcionalidade atendeu aos requisitos necessários para garantir sua utilização. Além disso, com base nos testes, pode-se observar que existem pontos que podem ser modificados, de modo a garantir uma melhor experiência para o usuário.

5. Conclusões

Este artigo descreveu o desenvolvimento de uma funcionalidade integrada a um Editor de Texto Coletivo (ETC) que permite identificar, através da visão computacional, expressões de usuários durante o período de escrita. O objetivo é fornecer informações para análise dos aspectos emocionais dos usuários durante a produção textual.

Além disso, a pesquisa apresentou os resultados de uma Revisão Sistemática de Literatura, focada nas ferramentas já empregadas por outros pesquisadores, que desenvolveram pesquisas relacionadas a este estudo. A RSL, serviu de embasamento para a escolha da utilização da biblioteca FaceAPI e o desenvolvimento na plataforma Visual Studio Code através da linguagem de programação JavaScript.

A aplicação utiliza uma webcam para identificar o tempo de escrita e a ocorrência de seis diferentes expressões básicas (alegria, tristeza, raiva, medo, nojo e surpresa) no decorrer da produção textual do autor. Durante esse processo, alguns fatores podem interferir na exatidão das expressões, como: a presença de óculos, pelos faciais, tatuagens e procedimentos estéticos.

Os dados coletados podem ser analisados por meio de um relatório em que será possível identificar as emoções básicas dos alunos, com base nas suas expressões no decorrer do processo de escrita.

A funcionalidade desenvolvida desempenha um importante papel ao favorecer o aprimoramento do processo de aprendizagem, fornecendo informações sobre as emoções dos alunos durante a criação de um texto. Ao monitorar e analisar as expressões faciais e os estados emocionais dos estudantes, a ferramenta proporciona uma compreensão mais profunda sobre o engajamento e associado à atividade da criação textual. Essa abordagem não apenas pode enriquecer a avaliação do desempenho acadêmico, mas também permite ajustes pedagógicos mais personalizados, promovendo um ambiente de aprendizagem mais eficaz e adaptado às necessidades emocionais dos alunos.

Até o momento, a funcionalidade não foi integrada em definitivo no ETC, pois outras implementações foram incorporadas, o que poderia impactar no desenvolvimento de ambos os projetos. Portanto, optou-se por implementar e testar a ferramenta localmente, antes da sua publicação no servidor da UFRGS.

Dessa forma, o próximo passo da pesquisa será incorporar a funcionalidade no espaço de produção e iniciar sua aplicação em estudos de caso. Para isso, serão construídas estratégias pedagógicas que utilizem a ferramenta ETC em uma atividade de produção textual, em disciplinas do ensino superior. Desse modo, será possível analisar dados sobre a aplicação da funcionalidade com professores e alunos.

A ferramenta foi desenvolvida atendendo às demandas do Núcleo de Tecnologia Digital Aplicada à Educação (NUTED), equipe responsável pela criação do Editor de Texto Coletivo (ETC). Como sugestões para projetos futuros, tem-se a inserção de tecnologias de expressões faciais mais complexas como, por exemplo: confusão ou dúvida. Além de incluir a análise de fadiga dos escritores, permitindo aos professores e/ou tutores identificar o rendimento dos alunos com base nesses dados.