1. Introducción

La computación afectiva representa uno de los desafíos actuales y emergentes en el en el campo de los sistemas y tecnologías de la información. Ésta se enfoca en el estudio y el desarrollo de sistemas y dispositivos que pueden reconocer, interpretar, procesar y estimular las emociones humanas. Rosalind Picard define que la computación afectiva es "la informática que se relaciona con las emociones, no sólo con las consideradas más importantes, como la alegría o la tristeza, sino también con el interés, el aburrimiento o la frustración, que son las que se dan en relación con los ordenadores" (Picard R., 2000). Su rápido crecimiento se ha visto reflejado en distintas ramas como seguridad, salud, marketing, robótica y educación, entre otras. Actualmente su objetivo es desarrollar dispositivos y sistemas que puedan reconocer, interpretar, procesar y/o simular las emociones humanas para mejorar la interacción entre el usuario y la computadora. Estos sistemas “afectivos”, por lo tanto, deben ser capaces de: 1) capturar y reconocer los estados emocionales del usuario a través de mediciones sobre señales generadas en la cara, la voz, el cuerpo, o cualquier otro reflejo del proceso emocional que se esté llevando a cabo; 2) procesar esa información clasificando, gestionando, y aprendiendo por medio de algoritmos que se encargan de recoger y comparar gran cantidad de casos, y que tienen en cuenta los estados emocionales del usuario y, en su caso, las determinadas por el ordenador; y, por último, 3) generar las respuestas y las emociones correspondientes, que pueden expresarse a través de diferentes canales: colores, sonidos, robots, o personajes virtuales dotados de expresiones faciales, gestos, voz, etc. (Baldasarri, 2016). Según la manera utilizada para capturar esos estados emocionales, los instrumentos de evaluación emocional se pueden clasificar en: instrumentos que miden sentimientos subjetivos, reacciones fisiológicas y expresiones emocionales.

1.1. Instrumentos para medir emociones

Instrumentos que miden sentimientos subjetivos. Se utilizan auto reportes para que las personas den a conocer sus emociones. Se clasifican en instrumentos de medición verbal, mediante los cuales los encuestados utilizan una escala para el registro de sus emociones, y de medición no verbal, que incluyen representaciones gráficas de la emoción (Agarwal & Meyer, 2009); es el caso de (Zhong, Qiao, & Zhang, 2019) en el cual tratan de sistematizar el uso de emoticones relacionándolos con el modelo Circumplejo de Russell. Instrumentos de medición fisiológica. Estos instrumentos miden los cambios fisiológicos relacionados con la emoción a través de técnicas no subjetivas. Los cambios se producen por el ritmo cardíaco, la respiración, la transpiración y la dilatación en la pupila, entre otros (Hartson & Pyla, 2012). Las señales fisiológicas se capturan a través de electromiogramas, electrooculograma, aparatos que miden la actividad electro dérmica, electrocardiograma o detectores de ritmo cardíaco. Trabajos como (Mehedi Hassan, y otros, 2019) experimentan con redes de creencia no supervisadas a partir de observaciones fusionadas de actividad electro dérmica, fotopletismograma y electromiograma. Para medir la actividad neuronal se utilizan dispositivos conocidos como interfaces cerebro computadora (BCI). En particular la Experiencia Afectiva de Usuario (UAX) en ambientes con Inteligencia Artificial (IA), los Sensores Biométricos resultan relevantes para el desarrollo de estos sistemas (Fernández-Ordóñez & otros, 2019) Instrumentos que miden expresión emocional. Están los que miden la expresión facial a través de cámaras que toman fotografías o videos, (Wei-Long & Bao-Liang, 2015) y los que registran y miden las expresiones vocales y tono de voz, por ejemplo: reconocer emociones en una conversación (Poria, Majunder, Mihalcea, & Hovy, 2019), analizar emociones y sentimientos sobre un discurso mediante la extracción de las propiedades acústicas de arousal y valencia (Chanchí & Córdoba. 2019),o sobre un analizador de emociones para contenidos musicales que obtiene una traza emocional una pista musical a partir del análisis de las variables acústicas arousal y valencia del modelo de Russell (Chanchí G y otros, 2019).

1.2. Métodos

Los métodos utilizados, en la computación afectiva, se basan en el procesamiento de los datos recopilados y etiquetados obtenidos mediante la ejecución de experiencias en laboratorios, donde se pueden obtener etiquetas (definidas con categorías predefinidas o de forma dimensional) de diferentes maneras: durante la interacción con el sistema o, retrospectivamente o, por el investigador durante o después de la interacción. De acuerdo con los tipos de datos que se utilizan en los sistemas propuestos, pueden clasificarse en sistemas unimodales - los que exploran una sola fuente de datos -, o en multimodales - los que combinan dos o más fuentes de datos -. Como trabajos unimodales, se pueden citar a: (van der Haar, 2019) donde se captura el rostro a través de videos (Zatarain Cabada, Barron Estrada, Halor-Hernandez, & Reyes-García, 2014), donde se captura la imagen del rostro (Wei-Long & Bao-Liang, 2015). Como trabajos multimodales, se pueden citar como ejemplos a: (Xu, Chen, Han, Tan, & Xu, 2019) donde agregan a la captura del rostro la posición de la cabeza, (Alepis & Virvou, 2006) donde utilizan cuestionarios, tecleo y micrófono, (Salmeron-Majadas, Santos, & Boticario, 2014) donde utilizan movimientos del mouse y teclado y, (Calot, Ierache, & Hasperué, 2019) donde se realiza la captura del tecleo. En la utilización de estados afectivos utilizando enfoques multimodales, existen distintos desafíos, como ser: decidir qué modalidades combinar, recopilar datos de entrenamiento, manejar datos faltantes, manejar diferentes tasas de muestreo e interdependencia de modalidades al construir modelos, decidir cómo fusionar datos de diferentes modalidades, decidir cómo evaluar los estados emocionales.

1.3. Interfaces

Para deducir el estado emocional de un individuo en un contexto multimodal (de ahora en más MM), se tiene que registrar, simultáneamente, diversa información biométrica. En la actualidad, se experimenta con el control de computadoras, dispositivos, robots, drones, juegos, etc., a través de Brain Control Interface (BCI o también conocidas como BMI), en la mayoría de los casos correspondiente a sistemas específicos e integrados a estos. Las interfaces para la interacción entre cerebro y computadoras (BCI) abarcan una amplia variedad de problemas. En sus inicios se buscó controlar máquinas a partir de la actividad eléctrica cerebral de un usuario entrenado para tal fin, es decir, el denominado BCI activo bajo la clasificación de Zander y Kothe. Más recientemente han surgido nuevos paradigmas en torno de este tipo de interacciones, que estos autores clasifican como BCI reactivo y BCI pasivo. El BCI reactivo, al igual que el BCI activo, tiene como objetivo el control de una máquina o dispositivo. La diferencia en este caso es que el usuario busca de manera consciente estímulos cuyos efectos en biomarcadores (por ej., EEG) serán detectados por la interfaz BCI y dispararán una determinada acción. El BCI pasivo recolecta información del estado del usuario (a partir de biomarcadores) con el objeto de evaluar/mejorar la interacción entre el hombre y el ambiente virtual, real o mixto.

1.4. Modelos Emocionales.

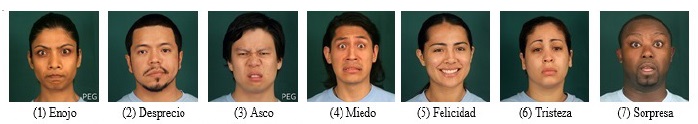

Desde el último medio siglo, se propusieron diferentes formas de modelar las emociones, representándolas desde diferentes perspectivas. Dos de ellas se utilizan ampliamente, una es el enfoque categórico (Ekman, 2005 cap. 3) y otra es el enfoque dimensional (Posner, Russell, & Peterson, 2005). El enfoque categórico, desarrollado inicialmente por el psicólogo Paul Ekman, afirmó que había un conjunto de seis emociones básicas y universales que no están determinadas por las culturas, estas son: la alegría/felicidad, el miedo, la tristeza, la ira/enojo, el disgusto/asco, la sorpresa. Ekman incorporó en su última actualización al desprecio. Se presenta, en la figura 1, el conjunto de rostros representativos de cada emoción.

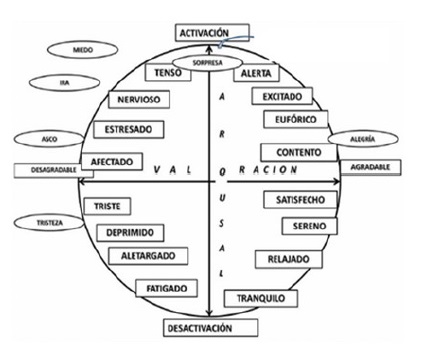

Por otro lado, el enfoque dimensional establece que los estados afectivos se distribuyen en un espacio continuo cuyos ejes dimensionales indican una cuantificación de una característica. Uno de los modelos más aceptados es el Circumplex Model of Affectivity, o Modelo Circumplex de Afectividad, también conocido como circumplejo o modelo Arousal-Valence. Este es un modelo bidimensional, sus ejes son Excitación o Arousal (relajado vs. excitado) y Valencia o Valence (placer vs. disgusto). Este permite entender cómo un individuo puede regular sus emociones, y a esta actividad la representa como el resultado de dos vectores de fuerza, que empujan al sujeto de una situación emocional a otra más placentera y mejor valorada. La idea fundamental que transmite este modelo es que los estados emocionales están mejor representados en un círculo con dimensiones bipolares que en dimensiones independientes. Russell representa las emociones mediante un modelo espacial en el que los conceptos afectivos caen en un círculo en el cual el número representa el vector o radial, en el siguiente orden: placer o agrado (0), excitación (45), activación (90), nervioso (135), afectado (180), deprimido (225), desactivado -somnolencia (270) y relajado (315) (Posner, Russell, & Peterson, 2005). La Figura 2, muestra el modelo mencionado. Existen intentos que tratan de suplir los problemas presentados tanto en el enfoque categórico como el enfoque dimensional como “La rueda de Ginebra” (Scherer, 2005), y trabajos que muestran la falta de estudios que discutan las emociones no básicas (Keltner & Cordaro, 2015).

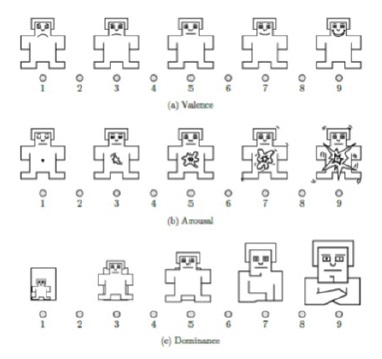

Otra herramienta que se utiliza para capturar emociones es SAM (por sus siglas en inglés Self-Assessment Manikin) propuesto por (Lang P., 1985) (Lang, Bradley, & Cuthbert, 2008). SAM es un método no verbal fácil de administrar para evaluar rápidamente el placer (valencia), la excitación (arousal) y la dominancia asociadas con la reacción emocional de una persona ante un evento. SAM se extiende desde una figura sonriente y feliz hacia una figura con ceño fruncido e infeliz cuando se representa la dimensión de placer; y se extiende desde una figura excitada con los ojos abiertos hacía una figura relajada con sueño para la dimensión de excitación. La dimensión de dominancia representa cambios en el control, con variaciones en el tamaño de SAM, una gran figura indica el máximo control de la situación. Los valores dimensionales provistos por SAM no necesitan ser transformados. Existen dos escalas, una en el rango 1-5, que coincide con las cinco representaciones del personaje de izquierda (1) a derecha (5). La segunda escala permite agregar cuatro valores intermedios, de esta forma se obtiene un rango posible de 1-9; en este caso, no se suele dibujar al personaje nueve veces, sino que se dibuja el punto posible en el medio. Ver figura 3.

2. Relevancia del problema

A lo largo de la historia, la intuición y los trabajos de muchos profesionales de diversas disciplinas han indicado la importancia de las emociones, así como la necesidad de conocerlas y aprender a relacionarnos con éstas de la forma más coherente posible. Ya en 1872, Darwin publicó su estudio sobre la expresión de las emociones en los animales y en los humanos, en el mismo muestra la utilidad de las emociones para la supervivencia en los procesos de adaptación, tanto en los animales de todas las épocas como en los humanos del pasado. Otros pensadores aportan al estudio de las emociones: en 1884 James y Lange proponían simultáneamente y por separado su teoría en la cual las emociones siguen a las reacciones físicas. Las teorías cognitivas argumentan que los pensamientos y otras actividades mentales juegan un papel esencial en la formación de las emociones. Schachter y Singer sugiere que la activación fisiológica ocurre primero. Lazarus, dentro de esta categoría propone que el pensamiento debe ocurrir antes que la experiencia de la emoción (Psicología y mente, 2019). Para el neurocientífico Damasio, experto en el proceso de las emociones, estas son un conjunto de respuestas químicas, físicas y neuronales que conforman un patrón y que influyen en la forma de evidenciar nuestras conductas. Después de las emociones llegan los sentimientos, los cuales tienen una relación más profunda con los pensamientos. Tanto las emociones como los sentimientos tienen valencias (esto quiere decir que pueden ser positivos o negativos) (Damasio, 2019). En la interacción entre el humano y la computadora pueden existir experiencias que desencadenen rendimientos pobres y errores que contribuyan a frustraciones del usuario. Acorde a los avances en el estudio de las emociones la computación afectiva adquirió relevancia en los últimos 20 años. En la detección de estados emocionales se utilizan distintas modalidades, se construyen sistemas unimodales o multimodales. A pesar del impresionante progreso realizado hasta el momento, son varios los problemas que aún subsisten entre los cuales se pueden nombrar: los desafíos técnicos asociados con la detección de construcciones psicológicas latentes (es decir, afecto) a partir de señales débiles incrustadas en canales ruidosos; el persistente problema de obtener etiquetas de verdad básica para la clasificación supervisada, cuando el acuerdo inter observador es generalmente bajo (ejemplo: el usuario tendrá que marcar en SAM su percepción del estado emocional. ¿Será el real?). Las ventajas hipotéticas de los enfoques MM para la detección de afectos incluyen (a) un modelo de expresión afectiva humana de mayor fidelidad, (b) una posible solución para abordar los datos faltantes causados por sensores unimodales, y (c) una solución al problema de los ruidos en distintos canales que son frecuentes en los enfoques Unimodales. Se reconoce ampliamente que la expresión afectiva humana consiste en una coordinación compleja de señales. Se espera que analizar múltiples señales y su interdependencia mutua produzca modelos que reflejen con mayor precisión la naturaleza subyacente de la expresión afectiva humana. ya que los enfoques MM pueden proporcionar capacidades de detección de afecto más continuas al basar sus decisiones en los canales disponibles.

2.1. Antecedentes del trabajo propuesto

El grupo de investigación del ISIER (Instituto de Sistemas Inteligentes y Enseñanza Experimental de la Robótica de la Universidad de Morón), se encuentra trabajando en un Framework Multimodal. Entre sus trabajos contribuyentes se destacan:

Aprendizaje de Robots por Refuerzo con supervisión y Control a Través de Bioseñales. (Ierache, Pereira, Iribarren, & Sattolo, 2012), (Ierache, Pereira, & Iribarren, Navigation Control of a Robot from a Remote Location via the Internet Using Brain-Machine Interface, 2014). Los anteriores trabajos sirvieron como base para el Control de artefactos y robots centrado en emociones: La aplicación desarrollada permitió la captura y almacenamiento de las señales de emociones leídas por el BCI (Emotiv EPOC), durante un tiempo determinado mientras se estimuló al usuario con una fuente externa (presentación con imagen y sonido, llamadas 911) (Ierache, Nervo, Pereira, & Iribarren, 2014). Influencia en el estado biométrico emocional de personas y Explotación de datos EEG y parámetros fisiológicos de usuarios interactuando en contextos virtuales: La investigación se concentra en el desarrollo de sistemas con el empleo de BCI pasivos que puedan evaluar las reacciones de una persona que está siendo entrenada en un ambiente virtual para ejecutar tareas críticas (Ierache, Nicolosi, Ponce, Cervino, & Eszter, 2018). Valoración del estado de atención en contextos áulico con el empleo de interfase cerebro computadora (Ierache, J., Ponce, G., Nicolosi, R., Sattolo, I., & Chapperón, G. 2019). Dinámica de patrones de tecleo influencia del estado emocional de un individuo, línea de investigación en colaboración con FIUBA, (Calot, Ierache, & Hasperué, 2019), (Calot & Ierache, Multimodal biometric recording architecture for the exploitation of applications in the context of affective computing, 2017)

2.2. Framework Multimodal

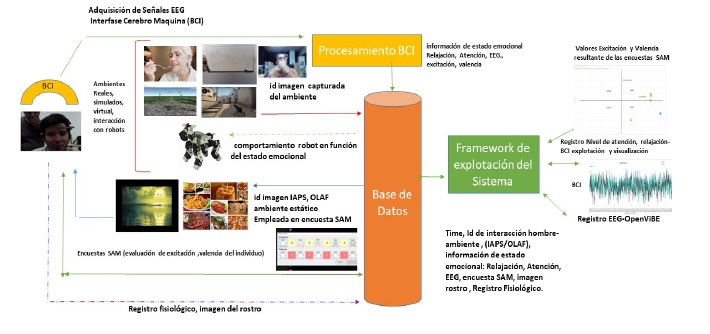

Se presentan resultados generales del Framework multimodal desarrollado que permite capturar y combinar distintas fuentes de datos, ofrece la posibilidad de obtener un modelo de expresión afectiva humana de mayor fidelidad en el marco de la computación afectiva. Para ambientes simulados o virtuales, en particular se recrean escenas y situaciones basadas en el mundo real, a las cuales se le suman el registro de información biométrica relacionada especialmente con el estado emocional, en especial frente a situaciones críticas. Se trabajó en situaciones generadas en simuladores de vuelo, como así también en ambientes de consumidores de alimentos y ambientes áulicos. Es importante destacar que los desarrollos, en el contexto de la computación afectiva, tienden a estar acoplados con la aplicación específica de un dominio de problema en particular, los sistemas de registro resultan propietarios y con baja capacidad de explotación de sus datos fuera del software del sistema integrado. Para el desarrollo del Framework se consideraron como entradas principales por un lado la captura de las ondas cerebrales con el empleo del BCI (Neurosky1,/ Emotiv2), y sus algoritmos, sumando la toma de “capturas de pantalla” y rostro de usuario. En particular para el empleo del BCI Neurosky se considera: Relajación, indica el nivel de "calma" o "relajación" mental, el valor varía de 0 a 100, y aumenta cuando los usuarios relajan la mente y decrece cuando están inquietos o estresados. El medidor cuantifica la capacidad de encontrar un estado interno de atención plena y puede ayudar a los usuarios a aprender cómo autocorregirse y encontrar el equilibrio interno para superar situaciones de tensión; Atención, indica la intensidad del "foco" mental o "atención". El valor varía de 0 a 100. El nivel de atención aumenta cuando un usuario se enfoca en un solo pensamiento o en un objeto externo, y disminuye cuando se distrae. Los usuarios pueden observar su habilidad para concentrarse usando el algoritmo. El desarrollo del Framework de registro de bioseñales correspondiente al BCI se implementó en el lenguaje C#, utilizando la librería ThinkGear.dll, la cual posee las funciones necesarias para interpretar las señales. Esta aplicación registra los metadatos de atención y relajación en un rango entre 0 y 100. Asimismo, también registra los datos en hz de las ondas cerebrales. La estructura de los datos que registra es la siguiente: HORARIO_DE_PC, TEST_NAME, TEST_COMMENT, PORT, ROW_TIME, POORSIGNAL, ATTENTION, RELAJACION (también llamada Meditación), EEGPOWER, EegPowerDelta, EegPowerThetha, EegPowerAlpha1, EegPowerAlpha2, EegPowerBeta1, EegPowerBeta2, EegPowerGamma1, EegPowerGamma2. El sistema de captura de imágenes del entorno virtual en el que interacciona el usuario se implementó en el lenguaje C# y registra en la base de datos: SECCION, IDENTIFICADOR, DATE, IMAGE, DESCRIPCION. La base de datos que captura imágenes se implementó en SQL Server. Para la visualización de resultados se incorporaron funcionalidades que permiten: consulta, filtros y la selección de datos y metadatos a graficar con el empleo de herramientas como Power BI. Para la experimentación se utilizaron imágenes del IAPS (recopilado por el Center for the Study of Emotion & Attention de la University of Florida en Gainesville, FL, Estados Unidos). Estos elementos varían en ciertos periodos de tiempo, momentos de relajación y momentos generados por imágenes que no contribuyen con el estado de relajación. Las imágenes empleadas pueden ser seleccionadas por los directores del experimento. Se sumaron las funcionalidades para registrar el test de SAM durante la experimentación con el usuario, registrando su resultado en la BD. Se efectuó el estudio de API para la integración de Herramienta Open BCI3, con la interfaz cerebro máquina (Neurosky) de esta forma se espera visualizar la información de BCI y realizar su captura y registro en BD. Se envía la foto de rostro a un servidor de imágenes, con su identificador y el timestamp, para la utilización de servicios de reconocimiento de emociones de fase Microsoft3 y así sumar información relativa a valores de reconocimiento de imágenes del rostro con relación a Enojo, Desprecio Disgusto, Miedo, Felicidad, Neutro, Tristeza, Sorpresa. Esta información se completa con la integración del BCI Emotiv Epoc, como así también la del BCI Neurosky. De forma independiente se puede seleccionar el BCI a emplear. Se muestra en la figura 4 la arquitectura conceptual para la experimentación con el Framework. Representa distintos contextos de empleo: simuladores, educación, gastronómico, interacción con robots.

Para la explotación se establece una secuencia del protocolo genérico experimental con independencia del ambiente. Este se conforma de las siguientes fases:

Primera Fase -registro SAM sin imágenes con el objetivo de valorar el estado emocional inicial del individuo previo al inicio del experimento. (se presenta imagen en negro)

Segunda Fase -presentación de estímulos a través de imágenes, en particular se aplican imágenes de los datasets IAPS (Lang, Bradley, & Cuthbert, 2008) o imágenes OLAF (Micolli y otros 2016), estas últimas solo para el contexto gastronómico, las cuales contienen valores de excitación y valencia correspondientes a los cuadrantes del modelo de Russell. Se muestran durante n segundos un total de n imágenes, finalizado el tiempo se realiza una encuesta SAM para valorar el estado emocional del individuo, a la cual se transforma en sus correspondientes valores de excitación y valencia en correspondencia con el modelo de Russell

Tercera Fase - Desarrollo. En esta fase se contemplan: los contextos (reales, virtuales, simulados, interacción con robots), cada uno con el registro del sujeto de prueba: el EEG empleando el BCI, captura de rostro del individuo y registros fisiológicos. Se capturan imágenes del contexto de actuación durante el desarrollo del experimento según sea el caso: ambiente real (áulico, gastronómico), simulado (vuelo, conducción automóvil), virtual (ambientes con RA y RV juegos), interacción con artefactos (robots).

Cuarta Fase -finalizada la experimentación se realiza al individuo un nuevo test de SAM, presentando una imagen neutra (pantalla en blanco) para registrar el estado emocional final.

3. Casos de Pruebas del Framework multimodal

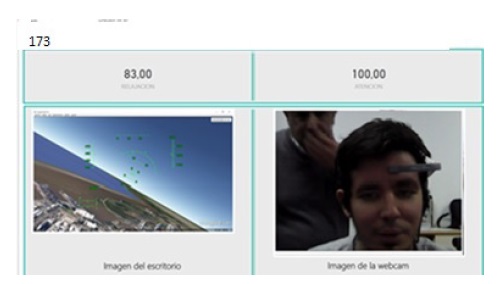

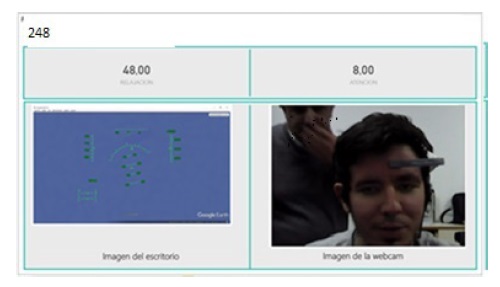

Se desarrollaron distintas pruebas para comprobar el funcionamiento del Framework multimodal, en su versión inicial se realizó un test parcial en ambientes dinámicos, cuyos resultados se muestran en (Ierache, Nicolosi, Ponce, Cervino, & Eszter, 2018), empleando el entorno del juego virtual “Counter Strike Global Ofensive”.En este trabajo presentamos los resultados avanzados obtenidos de una prueba principal, para la cual se seleccionó un ambiente virtual dinámico representado por un simulador de vuelo, en particular se emplea en el Framework MM el BCI Neurosky, registrando los niveles de atención y relajación del sujeto de pruebas, completando la información con el resultado de las respuestas de este a través de las encuestas SAM. Se presenta a continuación las imágenes provistas por el Framework, para un instante determinado en relación con la situación del contexto dinámico, en este caso las imágenes correspondientes al vuelo y los valores asociados de relajación y atención del usuario. Se puede apreciar en la figura 5 la imagen registrada (173) correspondiente al máximo nivel de atención (100 %) y un muy buen nivel de relajación 83 %, durante una maniobra de viraje del sujeto de pruebas. En la figura 6 se puede apreciar la imagen (248), previo a la pérdida del control de la aeronave el valor mínimo de atención 8 % y el bajo nivel de relajación 48 %.

Figura 5 imagen registrada correspondiente al máximo nivel de atención durante una maniobra de viraje

Figura 6 Imágenes registrada del contexto virtual del simulador y del rostro durante la pérdida del control de la aeronave

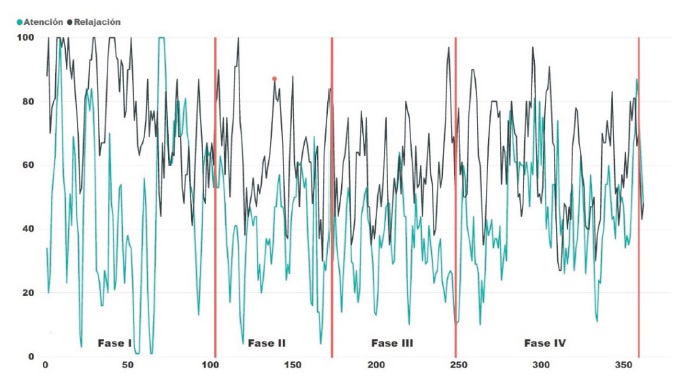

En la figura 7 se muestra el registro completo de los niveles de relajación y de atención durante la prueba realizada en el contexto virtual del simulador de vuelo, durante las cuatro fases del experimento.

Se puede observar en la figura 8 los resultados registrados por el Framework MM para la configuración de este caso de pruebas, el que emplea el test de SAM y el registro de señales del BCI, (porcentaje de atención y de relación del usuario, EEG, los que son transformados a valores de Excitación-Valencia), representando los distintos estados emocionales del sujeto de prueba: previo al inicio del vuelo (fase I), frente al estímulo de una imagen IAPS (fase II) y al finalizar el vuelo en el simulador (fase IV). La fase III se corresponde con los estímulos del ambiente de simulación y la interacción del sujeto de prueba con el simulador de vuelo.

Al inicio del experimento, fase I, se muestra al usuario una imagen neutra (pantalla fondo negro) durante 10 segundos, luego se le pide al sujeto que complete la encuesta SAM, con el propósito de obtener una respuesta por parte del usuario en relación con su estado emocional y valorar de esta forma su situación emocional previa. El resultado se representa como Fase I en la figura 8. En segundo lugar, durante la fase II, se presentan imágenes de estimulación, al sujeto de prueba, empleando el conjunto de datos IAPS durante 10 segundos, y luego que registre su estado emocional en la encuesta SAM en función de la imagen mostrada, el resultado se representa como fase II en la figura 8. En tercer lugar, durante la fase III el sujeto inicia la simulación de vuelo con el despegue y luego vuelo libre, se registra su grado de atención y relajación. En cuarto lugar, durante la Fase IV luego de la finalización del vuelo, se le muestra al sujeto una pantalla neutra (fondo de pantalla color blanco), se le pide al usuario que complete la encuesta SAM registrando su estado emocional, se presenta su resultado como Fase IV, en la figura 8. Desde el inicio hasta el final del desarrollo de las cuatro fases que conforman la experimentación articuladas por el Framework MM, se registran los valores del BCI, en orden a atención, relajación y señales de EEG del sujeto de prueba, imagen de rostro, como así también las imágenes de estímulo: neutras, IAPS, y las capturadas del simulador de vuelo.

4. Discusión de los resultados

Se puede observar que los resultados de la Fase I (SAM: Alegre/ BCI: Eufórico) como la Fase II (SAM: Excitado/BCI: Alerta) se corresponden al primer cuadrante, (Figura 8) previo al vuelo simulado. Esto valida el estado emocional manifestado por el sujeto de prueba, en su registro SAM inicial con estímulo neutro y con estímulo de la imagen IAPS. Los resultados registrados durante el vuelo (Figura 7) evidencian que al inicio del vuelo la relajación es de 83% y la atención es de 100% (BCI: Alerta) correspondiente a las máximas obtenidas, durante una situación de viraje de la aeronave, luego del despegue. Estos resultados están en correspondencia con el estado emocional validado para la Fase I y Fase II para el primer cuadrante del modelo circunflejo (Figura. 2). Durante el desarrollo del vuelo, Fase III, el sujeto de prueba pierde el control de la aeronave, en coincidencia con su atención mínima 8% y relajación de 48 %, (BCI: Fatigado), para luego finalizar el vuelo al estrellarse. En la Fase IV, al finalizar el vuelo, se le pide al sujeto que complete el test SAM respondiendo su excitación y valencia al estado emocional: Afectado. Se obtiene al representar los datos del BCI: el estado emocional: Nervioso (Figura 8), ambos resultados se corresponden con el segundo cuadrante del modelo circunflejo. La tabla 1 presenta una síntesis de los resultados obtenidos por el sujeto de prueba durante el desarrollo del experimento, integrándolos en todas las fases: previas (Fases I y II), de desarrollo (Fase III), y posterior (Fase IV).

Tabla 1 Síntesis de resultados obtenidos.

| Fase | Estímulo/situación | Emoción Registrada (SAM/ BCI*) | Cuadrante | Relajación % | Atención % |

|---|---|---|---|---|---|

| I | Imagen neutra (pantalla en negro) | Alegre/Euforico* | 1° (++) | 78% | 63% |

| II | Imagen IAPS (Excitación +, Valencia +) | Excitado/Alerta* | 1° (++) | 87 | 57 |

| III | Despegue y vuelo libre | Alerta* | 1° (++) | 83 | 100 |

| Pérdida de control de la aeronave | Fatigado* | 3° (+-) | 48 | 8 | |

| IV | Imagen Neutra ((pantalla en blanco) | Afectado/Nervioso* | 2° (+-) | 75 | 28 |

5. Conclusiones

En este artículo se presenta un Framework multimodal que contribuye al desarrollo de ambientes de computación afectiva. Se obtiene la interacción de un usuario con el contexto específico seleccionado, en este caso se utilizó un simulador de vuelo (ambiente virtual), registrándose: parámetros biométricos de BCI (excitación y relajación), los datos del EEG y sus metadatos, originados por el sujeto de prueba; se capturaron las imágenes del rostro correlacionadas con los valores biométricos obtenidos. Los datos obtenidos en las distintas fases de nuestro protocolo fueron analizados y permitieron obtener una relación entre las encuestas SAM, los valores obtenidos por el BCI y los cuadrantes del modelo Circunflejo de Russell, permitiendo dar más información sobre el estado emocional del sujeto actor. El Framework brinda información valiosa sobre el estado emocional del usuario interactuando con su contexto, en este caso en ambientes de entrenadores/simuladores en particular si estos sistemas son de misión crítica. Otros contextos que se están evaluando son: el áulico, el gastronómico y la integración con robots. Las actuales líneas de trabajo se centran en obtener un modelo más robusto, integrando sensores de variación de HR y de conductancia galvánica, así como se explotarán las imágenes de rostros obtenidas para el reconocimiento de la emoción. Otra línea de investigación abierta se centra en la determinación de emociones por reconocimiento de voz, considerando su integración al Framework multimodal presentado.