1. Introducción

Durante las últimas décadas el sistema educativo español se ha orientado hacia el aprendizaje centrado en el estudiante, heredero de la filosofía de la implantación del Espacio Europeo de Educación Superior (EEES), con ajustes distintos según las materias, los grados y los Centros educativos. Este proceso ha propiciado que los docentes, expertos en los contenidos de las materias que imparten, se viesen motivados o forzados a replantear su propia acción docente, adquirir numerosos roles muy alejados a priori de su actividad docente, ser evaluadores de nuevos elementos metodológicos de los procesos de aprendizaje, convertirse en diseñadores expertos de contenidos digitales, y adquirir el gusto por el uso de la tecnología activa en las aulas. Pero este proceso de metamorfosis del docente se ha visto necesariamente acompañada de la necesidad de observar el proceso de enseñanza-aprendizaje, abriendo extensos campos de investigación que refuerzan la visión del docente.

En este contexto, la tecnología digital permite actualmente, de forma inmediata y sin ser un experto programador, acceder al administrador de las herramientas digitales a los registros o rastros de los usuarios, profesores y alumnos, cuando utilizan las plataformas digitales, bien al acceder a archivos, realizar tareas o actividades, abrir enlaces, buscar información, participar en foros, participar en chats o videoblogs, etc. Este inmenso banco de información queda registrado automáticamente tanto en entornos de e-learning, moocs, como en los campus virtuales, wikis, blogs, o páginas de redes sociales que complementan la docencia presencial. Este inmenso conjunto e datos está generando una corriente de investigación extensiva e intensiva que penetra en áreas de conocimiento muy diversas, generado una extensa literatura empírica, denominada Analítica del Aprendizaje o Learning Analytics (en adelante LA), que a partir de algoritmos estadístico-matemáticos de software permiten abordar aspectos que hasta ahora eran desconocidos en el proceso de aprendizaje, respondiendo a diversas tipologías de estudios: descriptivos, predictivos, diagnósticos y prescriptivos. Por tanto, dicho Learning Analytics1 contribuye a la medición, recopilación, análisis e informe de datos de los usos virtuales o digitales de los alumnos y sus contextos. Los investigadores del LA abogan por el uso de los datos, tanto de registros digitales, como de cualquier otra observación accesible que permita conocer más en profundidad el proceso de enseñanza-aprendizaje, aportando un impacto directo tanto sobre el comportamiento de los estudiantes como de los profesores (Long y Siemens, 2011).

Este trabajo utiliza los datos de registros del uso del campus virtual Moodle, de naturaleza descriptiva, y se combinan con información de carácter institucional y personal de los usuarios, siempre de tratados de forma anónima. El trabajo aporta una contextualización del estado de la cuestión, seguida de la descripción de los objetivos y metodología, la exposición de los resultados y concluye con las conclusiones y la discusión final.

2. Contextualización del estado de la cuestión

No es objetivo de este estudio hacer una exhaustiva revisión de la literatura ni un análisis sistematizado de los metadatos de las investigaciones publicadas (Rivera-Baiocch, 2019), sino referenciar algunas líneas de investigación que se enmarcan en el Learning Analiytics, definido como la recopilación, medición, análisis y presentación de datos sobre los estudiantes y sus contextos, para comprender y optimizar el aprendizaje y los entornos en que se produce (Long et al., 2011), refiriéndose al uso de un amplio rango de datos producidos y gestionados en favor de los estudiantes a fin de evaluar el progreso académico, predecir el rendimiento o detectar potenciales problemas (Rojas-Castro, 2017).

Es cita obligada Long y Siemens (2011) quienes señalan que el LA permite penetrar en la niebla que oscurecía los procesos de aprendizaje, con implicaciones para todos los agentes, desde los docentes (conocer el comportamiento, rendimiento o ritmo de aprendizaje de los estudiantes), los estudiantes (información particularizada de su aprendizaje, feedback de reorientación), y los gestores de los centros (verificar el uso eficiente de los recursos, identificar ventajas competitivas, mejoras en la calidad). Para Ifenthaler y Widanapathirana (2014) el LA analiza, integra y sistematiza la información dinámica sobre los alumnos y sus entornos de aprendizaje, modelando el perfil de los estudiantes, proyectando resultados posibles y optimizando el proceso de aprendizaje y el ambiente en el que se desarrolla. Rojas-Castro (2017) incide en el uso de distintas técnicas y métodos de investigación e identifica varias categorías de estudios, orientados al: i) campo de estudio: fronteras, alcances, métodos, usuarios, etc., ii) proceso de aprendizaje: métodos de evaluación, análisis, comprensión, mejoras, etc., y iii) conjunto de herramientas analíticas: marco, diseño, implementación y evaluación.

Buckingham y Ferguson (2012) identifican el nacimiento del LA en el desarrollo del e-learning, la minería de datos que genera grandes matrices de datos (big data), el interés por optimizar las oportunidades del aprendizaje masivo en línea y la inquietud por disponer de mejores indicadores y resultados. Su explosiva expansión dibuja una línea divisoria difusa entre campos de investigación próximos, entroncando con la minería de datos, la inteligencia artificial, el internet de las cosas, la inteligencia comercial, etc. (Stewart, 2017), integrando datos de múltiples fuentes en los sistemas de gestión educativa (MacFadyen & Dawson, 2010), en distintas comunidades de aprendizaje, compartiendo herramientas de extracción, análisis de datos, técnicas y metodologías, en una fructífera intersección y colaboración científica (Siemens & Baker, 2012).

Particularizando el uso del LA en entornos en los que se produce el aprendizaje (Buckingham & Ferguson, 2012; Saqr el al., 2017), se desarrollan herramientas que señalizan acciones de mejora de las propuestas educativas (Suthers & Verbert, 2013), y que extraen nuevo conocimiento para mejorar la acción docente (Dawson et al., 2014; Gewerc et al., 2014), y que favorece la toma de decisiones de los estudiantes concernientes a su proceso de aprendizaje (Asif et al., 2017; Bogarín et al., 2018), identificando métodos analíticos, señalizando el impacto en los usuarios (Greller & Drachsler, 2012; Martin & Sherin, 2013; Siemens, 2013), incidiendo en la ruptura de la de tradicional concurrencia espacio-temporal de los elementos del aprendizaje, estudiantes, docentes y objeto, (Vihelmson & Scwanen, 2020).

Coll et al. (2017) identifican el diseño de algoritmos para la automatización de la extracción de los datos, siendo numerosos los que se centran en desarrollos de herramientas de grafología visual para presentar los resultados de forma inmediata, sencilla y sistematizada (Fuente-Valentín & Burgos, 2015; Fuente-Valentín el al., 2015), o en la determinación del propio marco, diseño, implementación y evaluación de las herramientas (Ali et al., 2012).

Stewart (2017), Ferguson y Clow (2017) y Banihashem et al. (2018) se centran en la recopilación y posterior análisis de datos sobre los estudiantes, contextos e interacciones con los sistemas, generando perfiles de alumnos, modelando un aprendizaje personalizado y adaptable. Sampson (2017) clasifica los usos de los registros electrónicos para definir patrones de uso según que los datos sean estáticos (variables demográficas individuales, sociales, familiares o académicas) o dinámicos (referidos al proceso de aprendizaje, comportamiento, compromiso o rendimiento).

Haya et al. (2015) ofrecen una descripción tipificada del proceso de aprendizaje de los estudiantes, y Brown (2012) y Ferguson (2012) señalan la importancia de que las herramientas analíticas tengan soporte en una fundamentación teórica sólida según la naturaleza de los datos a recopilar, procesar y presentar. Un enfoque distinto es evaluar la validez de las herramientas o algoritmos diseñados para identificar tipologías de estudiantes, como por ejemplo según el ritmo de aprendizaje, con diseño de programas específicos de ayuda temprana (Kaur et al., 2015), o abordar el diseño y la revisión de conductas y comportamientos esperados en el aprendizaje de los estudiantes (Lockyer et al., 2013).

Buckingham y Ferguson (2012) distinguen diversos niveles de análisis: el nivel micro (estudios de caso o de aula), el nivel meso o institucional (analíticas académicas) y el nivel macro (referidas a un área geográfica). En concreto, el nivel micro aporta de información tanto del acceso asincrónico de los estudiantes a las herramientas digitales, ritmos, frecuencias, franjas horarias, etc., como una visión de los hábitos de aprendizaje de los estudiantes o del desarrollo de competencias según las actividades docentes programadas, siendo una herramienta para identifica a los estudiantes en riesgo de abandono del curso que pudieran justificar intervenciones tempranas de corrección. Durall & Gros (2014) y Gros (2016) inciden en usar el LA para generar feedback sobre el aprendizaje de los estudiantes, dibujando el patrón de usos digitales, siendo una oportunidad para explorar el aprendizaje desde diversas perspectivas, enfoques y metodologías (Siemens, 2013).

A modo de síntesis, el trabajo se inscribe en el nivel micro, en el que inciden dos líneas de investigación apuntadas: i) clasificar e identificar de forma temprana a los estudiantes que registran ritmos lentos, y ii) abordar la existencia de relación entre las interacciones digitales y el rendimiento académico de los estudiantes, los niveles de participación y en su caso las tasas de abandono.

3. Metodología del estudio de caso

3.1 Objetivo y metodología

El objetivo del estudio es aportar evidencia sobre si en condiciones céteris páribus, (igual profesor, mismo sub-área de conocimiento y metodología docente) existe diferente comportamiento de los estudiantes en los usos digitales de las plataformas de apoyo a la docencia presencial, según el curso, género, o rendimiento académico, reflejo de variables individuales como la madurez y el compromiso con el programa formativo.

El enfoque de análisis se corresponde al nivel micro del LA (Buckingham & Ferguson, 2012), que encuadra el objetivo propuesto en un estudio de caso, en lo que Harrison y Killion (2007) identifican con la observación directa del profesor sobre el aprendizaje de sus estudiantes, para conocer mejor la propia acción docente, la dependencia de los usos digitales a la secuencia de la programación didáctica, las actividades de evaluación, la interacción entre la tipología de sus estudiantes y los resultados, así como ciertas actitudes.

3.2 Diseño y Participantes

El estudio abordó un diseño de análisis cuantitativo de tipo descriptivo, a partir de la información que aportan los registros de los usos que los estudiantes hacen de las herramientas digitales enlazadas en el campus virtual, Moodle (Desai et al., 2020), la información de carácter personal e institucional y la procedente de la evaluación del curso.

El estudio de caso se particularizó para dos asignaturas del área de Microeconomía, del Grado en Economía (GECO), de la Universidad Complutense de Madrid, impartidas en el primer cuatrimestre del curso 2019-20. Se acota a un grupo de primero y de cuarto, y para evitar heterogeneidad externa fueron impartidas por el mismo profesor con el mismo método didáctico y en el mismo semestre: docencia basada en clases expositivas, resolución de ejemplos de comprensión, prácticas y seminarios de trabajo, individuales y grupales, y con apoyo activo del campus virtual y otras herramientas electrónicas.

La población fue el total de estudiantes matriculados, sin realizar muestreo probabilístico, formada por 50 estudiantes en primer curso (un grupo de 8) y 61 en cuarto curso, excluidos aquellos que en las dos primeras semanas anularon matrícula o, en el caso de cuarto, cursaban Erasmus-out. En concreto (tabla 1) en primero el 81.63% de estudiantes se matriculó con un documento de nacionalidad española (DNI), y el resto con un documento de identificación extrajera (NIE), el 63.26% es varón, el 67,35% cursaba primera convocatoria, y el porcentaje medio de asistencia a clase fue del 63.265%, según 11 registros puntuales. En cuarto curso, el 81.48% se matriculó con DNI, el 51.85% es varón, el 92.59% cursaba primera convocatoria, y asistió en media a clase el 73.06%, según conteo de 17 registros. Cabe destacar, a favor de los alumnos de cuarto, el bajo porcentaje de repetidores entre los estudiantes de cuarto (25.24 puntos porcentuales de diferencia respecto a primero), y el alto porcentaje de asistencia a clase (9.79 puntos de diferencia).

3.3 Instrumentos y procedimiento

Se combinaron diversas bases de datos con información primaria (Sampson, 2017), algunas de gran tamaño como los registros digitales del campus virtual, y otras con datos que caracterizan a los individuos (Lodge & Corrin, 2017). En concreto, 1) información de naturaleza institucional: identificación, convocatoria, estudiantes Erasmus, años en la Universidad, etc.; 2) registros digitales (campus virtual Moodle), según Iglesia-Villasol (2019) y 3) de las calificaciones: evaluación continua (EVC), dos pruebas de evaluación parcial (PEP1 y PEP2) y 3), y prueba de evaluación final (PEF). En concreto, en primer curso se extrajeron 8,764 registros de usos digitales de los alumnos y 285 del profesor y en cuarto 19,668 y 367, respectivamente.

La extracción de la información se realizó durante el curso 2019/2020, bajo un algoritmo estadístico que recodifica los ítems de identificación personal en cumplimiento con la protección de datos, garantizando el anonimato (Pardo & Siemens, 2014, Slade & Prinsloo, 2013, Drachsler & Greller, 2016). El análisis de los datos se realizó con herramientas de Excel y el paquete estadístico SPSS-19.

4. Análisis y resultados

Inicialmente se realizó un análisis de varianza (ANOVA), como generalización del contraste de igualdad de medias, para confirmar que eran dos muestras independientes, con una significación intraclase del 0.000 (tabla 2), considerado como factor discriminante el pertenecer al curso de primero o de cuarto. Se presentan los resultados para tres variables, convocatoria, asistencia y número de registros.

Tabla 2 ANOVA de igualdad de medias

| Pruebas robustas de igualdad de medias | Prueba de homogeneidad de varianzas | |||

|---|---|---|---|---|

| Estadístico Welch, Brown-Forsythe | Sig. | Estadístico Levene | Sig. | |

| Convocatoria matrícula | 9.680 | .003 | 37.871 | .000 |

| Porcentaje asistencia | 87.469 | .000 | 42.073 | .000 |

| Número registros | 24.752 | .000 | 8.138 | .005 |

Una vez confirmada que son muestras independientes por curso, se aporta un análisis exploratorio y descriptivo de los estadísticos básicos para identificar patrones de uso diferenciado por curso, género, según la brecha digital y rendimiento.

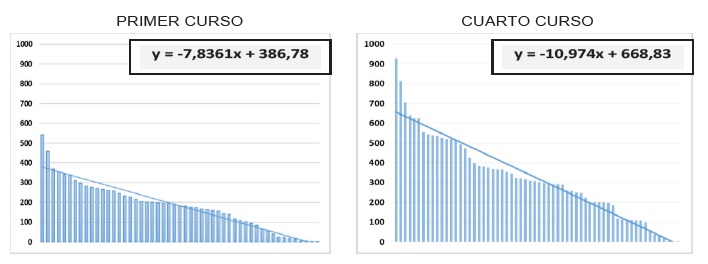

Una primera aproximación a los datos mostró una elevada dispersión en los usos digitales de los estudiantes, elevada asimetría y perfiles polarizados según el curso (tabla 3). Así, ante un elemento común como es la metodología docente, la estructura y rúbrica de evaluación continua y el mismo profesor, los estudiantes de cuarto tenían un uso más intensivo del campus virtual (media de 322.43 frente a 180.44 en primero), confirmado por la línea de tendencia de ajuste lineal (figura 1), tanto en la ordenada como en la pendiente (ésta última con un diferencial de tres puntos, -10.97 en cuarto frente a -7.84 en primero). Además, mientras en primero la media semanal era de 12,89 registros (2% del total), en cuarto alcanzaba 23,04 registros (1.64% del total), resultado reforzado tanto por el coeficiente de asimetría respecto de la media (0.561 en primero y 0.572 en cuarto) como los cuartiles del porcentaje de accesos (0.55, 1.47 y 1.95 en primero y 1.06, 2.05 y 2.78 en cuarto).

Particularizando, en primero los 10 estudiantes más activos digitalmente (porcentaje medio del 3.31% y media semanal de 25.21 registros) computaron el 39.128% del total de registros, mientras que los 10 menos activos (porcentaje medio del 0.21% y media de 1,38 accesos), aportaron el 2.14% del total. Comparativamente, en cuarto los 10 alumnos más activos registraron el 33.12% del total de accesos (porcentaje medio del 3.91%, y 46.54 accesos de media semanal), mientras que los 10 menos activos aportan el 2.40% del total de registros (en media el 0.24% y 3.38 accesos semanales).

A partir de los diferenciales de uso individual respecto de la media del total de alumnos se calculó el indicador brecha de uso digital (tabla 4): en primero el alumno A_22 es el más centrado (brecha: -0.04%) y en cuarto el alumno A_32 (brecha: -0,44%). Una visión complementaria la aportan los cuartiles de la distribución de la brecha digital, siendo respectivamente Q1= -48.46, Q2= -0.24 y Q3= 35.23 en primero, y Q1= -38.59, Q2= -6.65 y Q3= 46.70 en cuarto.

Según el indicador brecha digital (tabla 4), se agrupan los estudiantes en proactivos, sobreactivos, activos, subactivos e inactivos, siendo mayoritaria la inclusión de alumnos en la categoría activos en ambos cursos (36% en primero y 38% en cuarto), seguido de la categoría sobreactivos (20%) en primero y subactivos (23%) en cuarto.

Tabla 3 Estadísticos del total registros, %, media, y brecha de uso semanal.

| Primero | Cuarto | |||||||

|---|---|---|---|---|---|---|---|---|

| % total | Media semanal | Brecha digital% | % total | Media semanal | Brecha digital% | |||

| 5 más activos | AL_3 | 6.00 | 38.64 | 199.82 | A4_13 | 4.72 | 66.29 | 187.82 |

| AL_32 | 5.09 | 32.79 | 154.38 | A4_54 | 4.14 | 58.21 | 152.77 | |

| AL_12 | 4.09 | 26.36 | 104.50 | A4_25 | 3.59 | 50.36 | 118.66 | |

| AL_19 | 3.94 | 25.36 | 96.74 | A4_42 | 3.26 | 45.79 | 98.81 | |

| AL_10 | 3.79 | 24.43 | 89.54 | A4_52 | 3.18 | 44.64 | 93.84 | |

| MEDIA 10 más activos | 3.91 | 25.21 | 95.63 | 3.31 | 46.54 | 102.06 | ||

| % total | Media semanal | Brecha digital% | % total | Media semanal | Brecha digital% | |||

| 5 menos activos | AL_16 | 0.18 | 1.14 | -91.13 | A4_37 | 0.15 | 2.14 | -90.70 |

| AL_29 | 0.07 | 0.43 | -96.68 | A4_44 | 0.10 | 1.36 | -94.11 | |

| AL_42 | 0.06 | 0.36 | -97.23 | A4_31 | 0.03 | 0.43 | -98.14 | |

| AL_26 | 0.03 | 0.21 | -98.34 | A4_50 | 0.02 | 0.21 | -99.07 | |

| AL_39 | 0.02 | 0.14 | -98.89 | A4_51 | 0.01 | 0.14 | -99.38 | |

| MEDIA 10 menos activos | 0.21 | 1.38 | -89.30 | 0.24 | 3.38 | -85.33 | ||

| MEDIA todos | 2.00 | 12.89 | 0 | 1.64 | 23.03 | 0 | ||

Tabla 4 Clasificación de estudiantes según la brecha de uso semanal, por curso.

| Brecha Digital Media (%total) | ||

|---|---|---|

| Primero | Cuarto | |

| Proactivos: brecha positiva de >75% | 122,23 (12%) | 124,29 (10%) |

| Sobreactivos: brecha positiva entre 75 a 25% | 44,87 (20%) | 59,36 (18%) |

| Activos: brecha entre +25 y -25% | -0,21 (36%) | -1,08 (38%) |

| Subactivos: brecha negativa entre 25 y 75% | -50,68 (14%) | -51,62 (23%) |

| Inactivos: brecha negativa superior al 75% | -91,50 (18%) | -93,04 (11%) |

El análisis de la brecha digital por género (tabla 5) evidenció que tanto en el total como en cada una de las tipologías las mujeres fueron más activas que sus compañeros varones, tanto en primero como en cuarto curso: i) en primero la brecha media semanal es 12.78 para las mujeres frente a -8.81 entre los varones, siendo mayor el diferencial en cuarto curso, 17.86 entre las mujeres y -19.88 para los varones; ii) en todas las tipologías las mujeres se mostraron más activas que sus compañeros varones, con diferenciales elevados, por ejemplo de más de 20 accesos semanales en primer curso en la tipología de alumnos proactivos, aspecto que también se observa entre los alumnos de cuarto excepto en la tipología de proactivos, en los que los varones son excepcionalmente activos en el uso digital.

Tabla 5 Brecha digital media de uso semanal según género, asistencia y curso.

| Género | % Media asistencia clase | |||||

|---|---|---|---|---|---|---|

| Primero | Cuarto | Primero | Cuarto | |||

| Mujer | Hombre | Mujer | Hombre | |||

| Proactivos | 133.69 | 110.78 | 118.59 | 152.77 | 73.81 | 89.22 |

| Sobreactivos | 52.13 | 39.44 | 64.11 | 39.57 | 66.67 | 84.12 |

| Activos | 3.19 | -1.52 | 0.41 | -1.87 | 80.96 | 71.93 |

| Subactivos | -44.03 | -55.66 | -47.53 | -54.68 | 76.19 | 57.84 |

| Inactivos | -87.81 | -93.35 | -96.07 | -90.77 | 35.71 | 34.29 |

| Total | 12.78 | -8.81 | 17.86 | -19.88 | 63.26 | 73.06 |

El porcentaje medio de asistencia (tabla 5) confirmó el comportamiento diferenciado por cursos, dado que en el total y en cada una de las tipologías, en primero la distribución era más errática, siendo los alumnos activos los que tenían mayor porcentaje de asistencia (80.96%), seguidos de los subactivos (76.19%), mientras que cuarto se observó una relación positiva entre brecha y porcentaje de asistencia, siendo los estudiantes proactivos quienes registraron los mayores porcentajes de asistencia (89.22%), seguidos de los sobreactivos (84.12%). Además, los alumnos de cuarto curso proacivos y sobreactivos asisten con más frecuencia a clase (89.22% y 84.12% frente al 73.81% y 66.67% en primero).

La naturaleza de los registros digitales se muestra recodificada en 5 categorías, con notables diferencias en la distribución semanal y temporalidad (tabla 6): en primero las cuatro primeras semanas lectivas del curso computaron el 10.80% del total de registros, y las últimas cuatro el 39.86%, casi el triple, mientras que los estudiantes de cuarto curso fueron más uniformes temporalmente, pasando del 13.34% del total en las cuatro primeras semanas al 35.16% en las cuatro últimas. Esta temporalidad, con ciertos desfases, sigue estando condicionada al cronograma de actividades planificadas por el docente, con mayor intensidad en las cuatro últimas semanas lectivas, fechas en las que coincidieron en ambos cursos la evaluación parcial (PEP2) y final (PEF). Los accesos fueron mayoritariamente a los módulos de los cursos, recursos docentes y actividades formativas (R1 y R2), representando conjuntamente el 89.46% en primero y el 96.34% en cuarto curso.

Tabla 6 Registros por semanas y tipología, en porcentaje.

| Primero (%) | Cuarto (%) | ||||||

|---|---|---|---|---|---|---|---|

| Primeras 4 semanas | Ultimas 4 semanas | Total | Primeras 4 semanas | Ultimas 4 semanas | Total | ||

| R1_Módulos curso | 34.31 | 48.98 | 39.24 | 42.71 | 50.47 | 46.75 | |

| R2_Recursos curso | 59.94 | 48.03 | 50.22 | 54.81 | 46.06 | 49.59 | |

| R3_Informes y notas | 0.78 | 2.11 | 7.49 | 1.37 | 0.00 | 1.28 | |

| R4_Avisos y eventos | 4.48 | 0.55 | 1.38 | 1.11 | 3.46 | 1.89 | |

| R5_Perfiles | 0.49 | 0.32 | 1.66 | 0.00 | 0.01 | 0.50 | |

| Total | 10.80 | 39.86 | 100 | 13.43 | 35.16 | 100 | |

El estudiante conectado mostraba un uso bastante polarizado de las plataformas digitales, concentrado en consultar recursos del curso y módulos como correos, información o novedades, 89.21% en primero y 96.67% en cuarto.

En cuanto al rendimiento académico, la nota final (NT) se vinculó a varios elementos: evaluación continua, peso del 10% (EVC), dos pruebas de evaluación parcial, peso de 20% cada una, (PEP1 y PEP2), y prueba de evaluación final, peso del 50% (PEF). Destacó (tabla 7) que mientras en primero la calificación media obtenida es mayor en el PEP1 que en el PEP2 (5.04 y 4.43 respectivamente), en cuarto es la inversa (3.36 y 6.72 respectivamente). La calificación media en las PEF en primero fue 5.56, y la NT 5.33, mientras que en cuarto fueron 6.15 y 6.14, respectivamente, resultados que se justifican por: 1) el distinto grado de exigencia en la materia; 2) la dificultad y abstracción de la materia; 3) los estudiantes de cuarto refuerzan su motivación tanto con el objetivo de finalizar el grado como con la responsabilidad que asumen al estar seleccionando prácticas de empresa.

Por género, los varones de primero obtuvieron ligeramente menores calificaciones en las pruebas parciales PEP1 y PEP2 respecto de las mujeres, y mejoraron sensiblemente en la PEF (6.18 frente a 4.66) con una nota final superior (5.62 frente a 4.91). Sin embargo, en cuarto curso la nota media de las mujeres fue mayor en todas las pruebas determinado una mayor nota final, respecto a los varones.

Segmentando por nacionalidad, en ambos cursos los matriculados con NIE obtienen mejores notas medias en todas y cada una de las pruebas, parciales, finales y por tanto en la nota final, siendo ésta última 6.31 frente a 5.10 en primero y 6.36 frente a 6.09 en cuarto.

Tabla 7 Calificaciones según segmentaciones de la población.

| PEP1 | PEP2 | PEF | NT | ||

|---|---|---|---|---|---|

| Primero | |||||

| Calificación Media | 5.04 | 4.43 | 5.56 | 5.33 | |

| Género | Varones | 4.36 | 4.37 | 6.18 | 5.62 |

| Mujeres | 6.43 | 4.54 | 4.66 | 4.91 | |

| Nacionalidad | DNI | 4.92 | 4.26 | 5.36 | 5.10 |

| NIE | 5.52 | 5.09 | 6.49 | 6.31 | |

| Cuarto | |||||

| Calificación Media | 3.36 | 6.72 | 6.14 | 6.15 | |

| Género | Varones | 2.91 | 6.44 | 5.91 | 5.94 |

| Mujeres | 3.91 | 6.99 | 6.39 | 6.50 | |

| Nacionalidad | DNI | 3.34 | 6.50 | 6.02 | 6.09 |

| NIE | 3.49 | 7.88 | 6.61 | 6.36 | |

Analizando las calificaciones según la tipología por brecha digital, tabla 8, se apunta a una relación positiva entre el uso digital más activo con las mejores calificaciones, en la evaluación continua y final, con ciertas excepciones: en primero, destacó como excepción los alumnos subactivos, que remontaron a los activos tanto en la PEF y la NT, mientras que en cuarto el patrón estuvo menos consolidado, con las excepciones de los estudiantes sobreactivos que obtuvieron calificaciones medias superiores a los estudiantes proactivos en todos los elementos de evaluación, y los estudiantes subactivos tanto en la PEF y NT.

Tabla 8 Calificaciones según tipología brecha digital.

| Media brecha digital | PEP1 | PEP2 | PEF | NF | |

|---|---|---|---|---|---|

| Primer curso | |||||

| Proactivos | 122.23 | 5.70 | 5.53 | 6.63 | 6.22 |

| Sobreactivos | 44.87 | 4.57 | 4.88 | 6.43 | 5.90 |

| Activos | -0.21 | 5.69 | 4.53 | 4.86 | 4.90 |

| Subactivos | -50.68 | 3.97 | 2.83 | 5.86 | 5.19 |

| Inactivos (*) | -91.50 | 3.99 | 1.60 | 3.65 | 3.78 |

| Total | 0 | 5.04 | 4.43 | 5.56 | 5.33 |

| Cuarto curso | |||||

| Proactivos | 124.29 | 3.23 | 6.43 | 6.40 | 6.40 |

| Sobreactivos | 59.36 | 4.17 | 7.96 | 7.30 | 7.38 |

| Activos | -1.08 | 3.01 | 6.64 | 5.69 | 5.80 |

| Subactivos | -51.62 | 3.67 | 5.98 | 5.94 | 5.95 |

| Inactivos(*) | -93.04 | 1.02 | 2.13 | 5.06 | 3.45 |

| Total | 0 | 3.36 | 6.72 | 6.14 | 6.15 |

Nota:(*) no representativo, al no presentarse a las pruebas todos los estudiantes.

5. Discusión final y conclusiones

En la era digital el docente se ha adaptado a una nueva realidad docente e investigadora, asumiendo nuevos roles, que pasan por diseñar y evaluar nuevos entornos de aprendizaje, recursos para el autoaprendizaje y métodos de evaluación de conocimientos y competencias. El docente debe ser, competente digital, pero también un experto instructor en el uso de la tecnología educativa y metodologías activas para mejorar el proceso de enseñanza-aprendizaje (Bates, 2015). El uso de los nuevos espacios de aprendizaje con el soporte de herramientas digitales genera una inmensa corriente de datos que permite observar la adaptación de los estudiantes a los métodos de aprendizaje y generar aproximaciones cuantitativas del comportamiento de los alumnos. Así, la analítica del aprendizaje (LA) gestiona la información para identificar brechas en los usos en entornos educativos virtuales, pero también en los rendimientos de la educación (Lodge & Corrin, 2017), dado que los estudiantes pueden tener una interacción diferente con los recursos docentes, patrones y ritmos de uso digital, al igual que tienen su propio tipo de inteligencia, estilo de aprendizaje y han desarrollado en grados distintos competencias profesionales, personales y sociales. En esta línea, este estudio de caso o micro aporta evidencia sobre patrones del uso digital de los estudiantes y genera feedback formativo útil haciendo del docente un observador de su propia acción docente (Harrison & Killion, 2007).

El trabajo confirma que con el mismo docente igual metodología, existen ciertas diferencias de comportamiento y resultados entre los estudiantes de primero y cuarto curso. Así, la motivación y compromiso con el programa formativo parece diferir según que se esté al comienzo o final de los estudios universitarios, siendo mayor en cuarto curso.

Los registros digitales dibujan perfiles polarizados, con claras diferencias por curso: los estudiantes de cuarto utilizan más intensivamente y de forma continuada el campus virtual, además el indicador brecha digital definido exhibe alta dispersión y elevada asimetría entre los estudiantes proactivos y activos con respecto a los subactivos e inactivos, y los mayores diferenciales entre ambos cursos se observan entre los activos. Por género, en el total y en cada una de las tipologías, las mujeres son más activas que sus compañeros varones, tanto en el curso de primero como de cuarto curso, al igual que refieren Martínez et al. (2021) al señalar que las mujeres con distinto comportamiento presentan diferencias en la gestión del tiempo. Según el porcentaje de asistencia a clase, en primero la distribución es más errática mientras que en cuarto se observa una relación positiva clara entre brecha y porcentaje de asistencia.

Respecto a la temporalidad, los accesos son mayoritarios en las últimas cuatro semanas del curso, respecto de las cuatro primeras, con mayores diferenciales en primer curso. El uso que los estudiantes hacen de las herramientas digitales sigue siendo mayoritariamente a módulos de los cursos y los recursos docentes y actividades formativas, con diferencias significativas entre primero y cuarto curso.

Mientras que los estudiantes de primero obtienen mejor nota media en la primera prueba de evaluación parcial que en la segunda, en cuarto es la inversa, siendo la calificación en la prueba de evaluación final, hecho que refleja la dificultad y abstracción de la materia, el distinto grado de exigencia y la motivación adicional de los estudiantes de cuarto curso por finalizar con éxito el grado. Cabe reflexionar sobre el efecto del cronograma del programa docente y de evaluación, así como la concentración de las pruebas de evaluación en ciertas fechas, que afecta al porcentaje de presentados y aprobados (Florido et al., 2019), pudiendo ser causa del fracaso escolar la concentración de exámenes, según la opinión de los estudiantes (Martín et al., 2003).

Segmentando por género, en primero los estudiantes varones obtuvieron peores calificaciones en las pruebas parciales remontando en las finales, mientras que en cuarto las mujeres registraron mejor nota media en todas las pruebas y en la nota final respecto a los varones. Por tipología según la brecha digital, apunta a una relación positiva, con sus excepciones, entre mayor uso de los recursos digitales y mejor calificación, si bien no puede ser concluyente ni generalizada: En esta línea, Plaza de la Hoz (2014) relaciona el rendimiento académico y la intensidad en el uso de la red con diferencias por sexo, y García-Valcárcel y Tejedor (2017) destacan que los alumnos con mayor rendimiento identifican que las TIC tiene un alto potencial de apoyo en sus estrategias de aprendizaje, mientras que Iglesia (2020) apunta a una relación positiva que sigue estando condicionada al cronograma docente y de evaluación.

Como síntesis, se constata el comportamiento dispar entre los estudiantes de primero y cuarto, con una fuerte brecha en el uso digital entre los estudiantes proactivos e inactivos. Disponer de herramientas que permitan este análisis en fases tempranas y acompasado al avance del curso, puede ser útil para generar feedback y diseñar acciones de intervención para recuperar a los estudiantes que muestran un comportamiento errático, signos de subactividad y posible abandono del curso.

Algunas de estas conclusiones orientan hacia futuras investigaciones, en la línea con Ferguson et al. (2016), para abordar aspectos más concretos de los hábitos digitales de los estudiantes, evaluar la adquisición de conocimientos y el desarrollo de competencias durante el proceso de aprendizaje, lo cual requiere disponer de información individual e institucional más completa que excede los límites de este estudio. No obstante, este trabajo es una guía para la adaptación de la docencia presencial en semipresencial, máxime en las circunstancias del covid-19, que en muchos casos se mantendrá en el futuro de forma complementaria o sustitutiva, según la evolución de realidad sociosanitaria.