1.Introducción

En las últimas décadas ha aumentado la preocupación por la calidad de la formación impartida por las Instituciones de Educación Superior. Pensando en la educación superior (ES) como motor del desarrollo económico y sociocultural de los países, se está prestando mayor atención a los procesos de enseñanza y aprendizaje, en particular a las competencias que los estudiantes presentan al final de su formación y transición al mercado laboral. Unas sociedades más democráticas e inclusivas, así como unas economías más sostenibles y competitivas, requieren tasas más altas de adultos con ES. Se considera que los complejos problemas actuales demandan personas con capacidad de análisis y de resolución de problemas, con capacidad de pensamiento crítico y creativo, y con disponibilidad para la formación continua, siendo estos atributos individuales muy dependientes de la calidad de la formación impartida por la universidad.

Algunas organizaciones internacionales y modelos pedagógicos cuestionan las prácticas tradicionales de enseñanza, basadas en la calidad de los libros de texto como archivos de conocimientos, en la capacidad del profesorado para transmitir o en la capacidad del alumnado para memorizar. Las nuevas orientaciones pedagógicas sostienen que lo que el estudiante aprende está más determinado por lo que hace que por lo que hace el profesor, dando mayor centralidad al alumnado y a los procesos por los que aprende o puede aprender mejor (EUA., 2021).

En los países europeos, con la Declaración de Bolonia, esta centralidad del estudiante cobró mayor expresión traduciendo al ECTS (sistema europeo de unidades de crédito) el trabajo realizado por el alumnado dentro y fuera del aula. Por otro lado, los métodos de enseñanza y aprendizaje más activos (basados en la resolución de problemas o en el trabajo por proyectos, por ejemplo), destacan el trabajo cooperativo entre estudiantes y entre estudiantes y profesores, así como el aprendizaje cooperativo y el trabajo en pequeños grupos o comunidades de aprendizaje, para reforzar un aprendizaje más activo y significativo, estando los currículos formativos definidos por las competencias o resultados de aprendizaje que se deben alcanzar (Johnson & Johnson, 2014; Kyndt et al., 2013; Vieira, 2014).

Estas cuestiones en la educación superior se ven reforzadas por la mayor cantidad y diversidad de estudiantes, asociada a los objetivos de mayor equidad y a la preocupación por la inclusión y promoción social de los grupos étnicos y socioculturales tradicionalmente más desfavorecidos en los contextos académicos (Almeida, 2019). Por ejemplo, en su informe Review of higher education and innovation: Portugal, la OCDE (2019, p.75) se congratula de la “gran expansión” del sistema de Educación Superior en Portugal en las últimas dos décadas, acercándose al objetivo europeo de que el 40 % de los adultos de 25/35 años tengan formación superior. Esta ampliación del número de estudiantes supone el acceso a la enseñanza superior (ES) de los llamados estudiantes “no tradicionales”, es decir, personas de mayor edad, con necesidades educativas especiales y pertenecientes a grupos socioeconómicos y culturales tradicionalmente alejados de la asistencia a la ES. Estos alumnos y alumnas son diferentes en cuanto a proyectos y expectativas, conocimientos previos y métodos de estudio, características personales y necesidades, lo que requiere cierta diferenciación pedagógica por parte de las instituciones y el profesorado (Almeida, 2019).

También vale la pena reflexionar sobre otros dos aspectos. Hoy en día, junto a las competencias curriculares (verticales), existe la necesidad de que la educación superior valore el desarrollo de las competencias blandas o transversales en su alumnado, donde los conocimientos y las habilidades cognitivas están al servicio del análisis y el afrontamiento de los problemas. Así, se habla menos de contenidos curriculares y más de conocimientos en acción, es decir, de habilidades blandas, habilidades instrumentales, habilidades interpersonales y habilidades sistémicas (taxonomía de habilidades desarrollada por el proyecto Tuning: Estructuras Educativas en Europa, en González & Wagenaar, 2008). Por otra parte, los procesos de enseñanza y aprendizaje están hoy modulados por las nuevas tecnologías de la información y la comunicación. Como se evidenció durante la reciente pandemia causada por el COVID-19, la población en general, y la académica en particular, tiene un amplio acceso a equipos electrónicos, y las tecnologías digitales de información y comunicación son omnipresentes e impactan en la forma en que las personas acceden a la información y en cómo se comunican entre sí (Flanigan & Kiewra, 2018). Sin embargo, algunos meta-análisis de la investigación en esta área atestiguan el papel decisivo de la implicación de estudiantes y profesores para un aprovechamiento real de dichas tecnologías en la calidad de los procesos de enseñanza-aprendizaje (Xu et al., 2020).

En este sentido, ha habido cierta preocupación por la calidad de la enseñanza del profesorado, entendida como movilizadora de la motivación y la calidad del aprendizaje del alumnado, que se han llevado a la práctica dentro de la denominada evaluación docente.

2.La evaluación docente que hace el alumnado

Para evaluar a los docentes y su enseñanza, se ha hecho un uso masivo de los cuestionarios de satisfacción de los estudiantes al final de las unidades del curso (Clayson, 2009; Seldin et al., 2010), en algunos casos con una importante fundamentación detrás (Morais et al., 2006; Risso, 2005). La facilidad para recoger y procesar la información, y una posible democratización y mayor participación de los estudiantes en la vida académica como stakeholders, explican la popularidad de este método, a menudo empleado sin la necesaria consideración de sus fuentes de sesgo (Fan et al., 2019). El problema se agrava cuando se pretende pasar de simplemente informar a asumir las puntuaciones del alumnado como sinónimo de la calidad del profesorado y de su enseñanza, valorando esta información en los procesos de contratación, salario o promoción profesional (Beecham, 2009; Galbraith et al., 2012; LERU, 2021; Spooren et al., 2013).

Esta situación se vuelve insostenible, ya que no se ha definido previamente qué es una enseñanza eficaz (Stark & Freishtat, 2014), mientras que se señalan varias limitaciones a los cuestionarios que evalúan la calidad de la enseñanza a través del juicio y la satisfacción del alumnado. Los estudiantes puntúan los ítems con criterios diferentes; incluso sus puntuaciones pueden reflejar más su experiencia subjetiva de aprendizaje que la calidad de la enseñanza, lo que hace imposible promediar las valoraciones de una asignatura, como se suele hacer para obtener la puntuación del profesor o profesora. Probablemente esta información, relativamente fácil de recoger y procesar, podría tener cierto interés práctico si se cruza con los datos de la observación de las clases, el análisis de los portafolios del profesorado o incluso los comentarios que el alumnado escribe en las preguntas de respuesta abierta de esos cuestionarios (Berk et al., 2004; Hornstein, 2017).

Podemos anticipar que los estudiantes tienen limitaciones, inherentes a su papel, para evaluar la calidad de la enseñanza de un profesor; sin embargo, como interlocutores de las prácticas docentes, es importante conocer las representaciones que formulan, ya que éstas también acaban condicionando su papel y su responsabilidad. Sin centrarnos en cuestiones de objetividad, exactitud y validez de los resultados en los cuestionarios de evaluación de la práctica docente a través del alumnado, en este estudio nuestra preocupación es tratar de entender qué significa para los y las estudiantes "este/a profesor/a me ayuda a aprender". Ciertamente, los aspectos motivacionales, relacionales, cognitivos y conductuales estarán presentes en las respuestas de los estudiantes a esta pregunta abierta, y es importante analizar cuáles son estos aspectos, su tasa de ocurrencia y su posible diferenciación en función de algunas variables personales de los estudiantes (por ejemplo, el género y la edad) o variables del contexto (por ejemplo, el área científica del curso, el nivel de formación de grado o postgrado).

3.Por qué esta investigación

Como otras muchas universidades, la de A Coruña pasa cada curso una encuesta por cada asignatura impartida por cada docente. Se evalúa a cada docente por separado, en el contexto de la asignatura, al finalizar el cuatrimestre de impartición.

El cuestionario al que responde el alumnado para cada profesor o profesora que le haya impartido docencia en ese curso consta de 23 preguntas, que se agrupan en cuatro factores (obtenidos mediante un análisis factorial exploratorio, AFE, y corroborados por un posterior análisis factorial confirmatorio, AFC): Metodología en el aula, Evaluación, Recursos y Tutorías. Además, hay una pregunta 24 que, a priori, es la conclusión de las anteriores: “Globalmente estoy satisfecho/a con el/la profesor/a de esta asignatura”. Todas se contestan en una escala de valoración tipo Likert de 7 puntos, donde marcar el 7 indica que se está totalmente de acuerdo con que la docencia o el profesor/a de la asignatura tiene esa característica y el 1 que se está completamente en desacuerdo.

De esta forma, a lo largo de 17 años se recogieron casi 650 mil encuestas. Concretamente, desde que se inició la evaluación online (curso 2003-2004) hasta que se comenzó el confinamiento por la pandemia y la docencia telemática (marzo de 2020), el número era de 640,819 (con un promedio de alrededor de 38 mil en cada curso académico (septiembre-julio).

Estos datos, dada su magnitud, han sido tratados con técnicas de Big Data, que arrojaron resultados altamente consistentes y estables a través de los años, destacando una cuestión por encima de las demás: en todos los modelos siempre es el mismo ítem el que mejor predice la satisfacción global. Y este ítem es el que dice: “Considero que este/a profesor/a me ayuda a aprender”.

Este resultado sin duda es interesante e inmediatamente llamó la atención la relevancia del concepto de “ayudar a aprender”, pero ¿qué quiere decir, realmente? ¿Qué significa para los y las estudiantes que responden a esta encuesta y puntúan esa pregunta?

Ante la ausencia, que sepamos, de investigación previa sobre este tema en contexto universitario (existe para otros niveles, como Sandoval et al., 2020), la idea que surgió enseguida tras el resultado del trabajo con macrodatos fue que, para saberlo, había que preguntar. Y realizar una investigación cualitativa.

Para ello, en el curso siguiente al del confinamiento por la pandemia, en el cual seguían vigentes la mayoría de las medidas de prevención de la COVID-19 se diseñó una encuesta, con una única respuesta abierta, en la que se pedía que se explicase qué se quería decir cuando se contesta a ese ítem y qué significados se les da a las puntuaciones altas y a las bajas.

En este trabajo se presenta la primera aproximación al análisis de los datos obtenidos, con la finalidad última de que los resultados puedan ser de interés y aplicación, no solamente en las evaluaciones docentes sino más allá de ellas.

4.Método

4.1 Participantes

Participaron voluntariamente 610 estudiantes de la Universidad de A Coruña (España), con edades comprendidas entre los 19 y los 58 años (M = 25.48; DT = 7.70), siendo el 61 % mujeres. El 83 % estaba matriculado en estudios de grado, mientras que el 17 % restante cursaba un máster universitario. El 22 % había realizado la Evaluación Docente cuatro o más veces y solamente un 5 % no había participado nunca.

4.2 Instrumento

El instrumento fue un informe para cubrir online con una pregunta de respuesta abierta en la que se pedía al alumnado que describiera qué quiere decir (o en qué piensa, qué se le viene a la cabeza) cuando contesta a la pregunta del cuestionario de evaluación del profesorado “Considero que este/a profesor/a me ayuda a aprender”. También se pedía que se indicara, por un lado, el significado que se dan a las puntuaciones altas y, por otro, a las bajas, en ese cuestionario de evaluación (el cual, como se mencionó antes, se puntúa en escalas tipo Likert de 7 puntos). No había límite de palabras a emplear.

Además, se preguntó cuántas veces se había participado anteriormente en la Evaluación Docente y se recogieron datos sobre variables personales como el sexo, la edad o los estudios que se estaban cursando.

4.3 Procedimiento

El instrumento se implementó en una aplicación para realizar encuestas online de la Universidad de A Coruña y se envió un correo electrónico motivador, en el que se hacía referencia al interés por la mejora del sistema de evaluación, a todo el alumnado matriculado en titulaciones oficiales de grado y máster. Se seleccionó esta población porque es a la que se dirige, cada fin de cuatrimestre, la Evaluación Docente. El mensaje contenía un enlace para acceder al instrumento. También se garantizaba a quien participara en esta investigación el tratamiento anónimo de las respuestas y el cumplimiento de la “Política de privacidad” de la Universidad. Además, la aplicación empleada impide que nadie pueda contestar más de una vez.

Los datos se recopilaron durante un mes en el año 2021, que fue el siguiente al del confinamiento por la pandemia provocada por la COVID-19. Aún se mantenían muchas de las medidas de prevención, como la limitación de aforos y el uso de mascarillas en los centros universitarios, lo que fue determinante para la elección del sistema de respuesta online.

4.4 Análisis de datos

Para la exploración y explotación de los datos se utilizaron dos programas de libre disposición: Voyant-tools (https://voyant-tools.org/) y AntConc v.4.1.1. para Windows (http://www.laurenceanthony.net/ software/antconc/). El primero funciona directamente online y el segundo requiere descarga e instalación (aunque existe una versión “portable”: sin instalación).

Se analizaron todas las respuestas en conjunto, pero, además, se hicieron distintos bloques con: a) los textos en los que se dice, de modo general, qué se entiende por “me ayuda a aprender”, b) los textos en los que se explica el significado de las valoraciones positivas, y c) los textos que explican las valoraciones negativas.

La codificación clásica y el establecimiento previo de categorías de análisis no fueron necesarios (excepto la mencionada clasificación en explicaciones de valoraciones positivas/negativas), ya que se trabajó a partir de palabras y a que el software utilizado permite ir añadiendo y quitando términos de la lista de exclusión (artículos, preposiciones, …), así como juntando palabras relevantes para el análisis (por ejemplo: a partir de la raíz “explic”: explica + explicaba + explicar + …), decidiendo en cada caso y en base al contexto qué es lo que se podía considerar equivalente (en el apartado de Resultados se van describiendo con más detalle las distintas etapas, a la vez que se proporcionan ejemplos de lo obtenido).

Previamente, fue necesario revisar y editar los textos, procedimiento común a cualquier investigación cualitativa que utilice este tipo de material, pero, en este caso, además fue necesario unificarlos en un único idioma, ya que algunos estaban escritos en gallego y otros en español. También se corrigieron las erratas de escritura y fallos ortográficos que se detectaron, excepto la acentuación de palabras. En este último caso, dada la elevadísima ausencia de acentos en palabras que los llevan (muy probablemente debidos a la escritura con dispositivos móviles sin teclado físico), en el fichero para el análisis mediante software se optó por suprimirlos completamente.

5.Resultados

De las respuestas recibidas, el 96 % fueron válidas a efectos de la presente investigación, lo que dio un corpus de 585 textos. La longitud de estos textos oscilaba entre 7 y 365 palabras, con un promedio de 67 palabras por persona. La mitad de los textos tienen 58 palabras o más. Un resultado a destacar es que los textos de las mujeres son algo más largos (68 palabras, de media, frente a 56 de los varones). También se encontró relación con el nivel de estudios (las repuestas más largas se dan entre el alumnado de máster), la edad y el área al que pertenece la titulación, pero el dato sin duda más interesante para los objetivos de esta investigación es que los textos en los que se explican las valoraciones positivas son mucho más largos que aquellos en los que se explican las negativas.

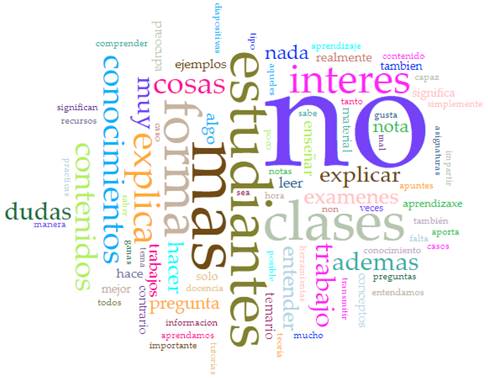

En una primera fase de análisis, únicamente se excluyeron preposiciones, artículos y conjunciones, de cara a obtener una imagen de partida. En la Figura 1 puede verse la relevancia relativa de las 75 palabras más empleadas, sin tener en cuenta “profesor/a/es/as”, “docente/s”, “alta” y “baja”, dado que al aparecer en prácticamente todos los textos distorsionan la representación gráfica.

Una cuestión que destaca inmediatamente es la relevancia de la palabra “no”, que en este caso está siempre asociada a lo que se considera que “no es” o “no hace” un buen docente. Por ejemplo:

“no tiene ningún tipo de interés”

“no aporta más información”

“no realiza ni un mínimo esfuerzo”

“no muestra tener ganas”

“no sabe llegar a los estudiantes”

En esta última frase se encuentra otra la de las palabras con especial relevancia: “estudiantes”, la cual da cuenta de la centralidad del propio alumnado (la relación con, o la perspectiva de), así como de las “clases” (que también destaca en la nube de palabras), a la hora de valorar si un/una docente les ayuda, o no, a aprender. “Más”, en cambio, aunque muy empleada, no se sitúa en ningún contexto en concreto.

También destacan términos cuyo importancia y contexto deben ser inspeccionado con más profundidad, como “interés”, “conocimientos” y “dudas”, y otro cuya significación es más oscura: “cosas”. Analizado este con más detenimiento, resulta que se enmarca siempre en valoraciones positivas, del tipo:

“se esfuerza porque aprendamos y entendamos las cosas”

“cuando me enseña cosas útiles”

“explica las cosas las veces que necesites”

“se interesa por que entendamos las cosas”

“para que nos queden las cosas claras”

“explica las cosas bien”

“aprendo cosas”

“propone cosas diferentes”

Otra cuestión de fundamental importancia y que muestra la necesidad de refinar de los resultados en las distintas formas en que aparece el verbo explicar. En la figura destacan “explica” y “explicar”, pero también están presentes las formas “explicación” y “explicaciones”, así como “explicado” o “explicarlo”.

Y esto nos introduce de lleno en la cuestión de mayor relevancia para la presente investigación, que es la que tiene que ver con cuáles son los conceptos utilizados para valorar positiva o negativamente a un/una docente, en el sentido de que “ayuda a aprender”.

Para poder analizar lo que se valora de forma positiva o negativa en relación con esa idea de que un/una profesor/a ayuda a aprender, y al significado que se da a las puntuaciones (altas o bajas) que se otorgan al ítem de la encuesta de evaluación docente en el que se hace esa pregunta al alumnado, se establecieron distintos códigos para los textos que explicaban las valoraciones positivas y para los que explicaban las negativas, después se correlacionó el código positivo/negativo con los sustantivos y verbos empleados en ellos. Con los resultados obtenidos, se agruparon los que se consideraron sinónimos y se volvieron a correlacionar. El resultado se expone a continuación.

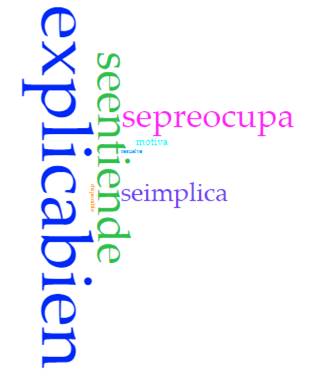

Por lo que se refiere a las valoraciones positivas, hemos encontrado que el docente que “ayuda a aprender” es el que “explica bien”, al que “se le entiende”, que “se preocupa” y “se implica”, que “motiva”, “aclara/resuelve” y está “disponible”. Estos términos, a su vez, están relacionados entre sí. En la Figura 2 puede verse la representación gráfica con el peso relativo de cada uno1.

De los términos que aparecen en la Figura 2, el más relevante, que hemos resumido en “explica bien”, se relaciona con ideas como:

“de forma adecuada”

“de forma clara”

“correctamente”

Y aparece en los mismos contextos que:

“las veces que haga falta”

“de distintas maneras”

“con/poniendo/usando ejemplos”

En este sentido, poner ejemplos se distingue como importante a la hora de las valoraciones positivas, pero no resulta explicativo por sí solo.

Por otra parte, se decidió unir lo relativo a los verbos “aclarar” y “resolver”, ya que parecían significar lo mismo (según el contexto que los acompaña), mientras que para el verbo “entender” fue necesario separar cuando “se entiende” al docente de los casos que se refieren a que el profesorado “entiende” a su alumnado, que es más un significado relacionado con la empatía, por lo que se ha podido observar en el análisis contextual. En cuanto a “se implica”, abarca también el estar implicado(a).

En cuanto a los términos utilizados para describir las valoraciones negativas de “me ayuda a aprender”, se siguió el mismo procedimiento descrito. Como se mencionó anteriormente, los textos, en general, son más cortos que los que explican las valoraciones positivas, y también suelen presentarse después, muchas veces introducidos por frase como “en cambio” o “por el contrario”. Los conceptos que más se repiten en la explicación de las valoraciones negativas se presentan en la Figura 3 2.

Un resultado a destacar en primer lugar es que varias de las frases que se emplean para describir las valoraciones negativas son justamente lo contrario de lo empleado para las positivas. Concretamente, lo relativo a “explicar” (en este caso “mal” o “no … bien”), que “no se entiende” (frente al “se le entiende” anterior”) y, más interesante, el “poco interés”, que podría contraponerse a la implicación y preocupación por el alumnado, a las que tanta importancia se les da como aspectos positivos.

Por otra parte, lo que parece más definitorio de quien no ayuda a aprender es que no se le entienda o que se confunda, seguido de no explicar bien. Y, aunque a veces coinciden en un contexto, “explica mal” y “no se entiende” aparecen como nociones relativamente relacionadas, aunque con sus propios matices. Así, explicar mal tiene más que ver con explicar poco, de forma insuficiente o con “leer” en clase, mientras que el no entender está más vinculado a términos como “farragoso” o “poco comprensible”.

Otros comportamientos que se revelan como muy importantes y relacionados con los mencionados viene dados por los verbos confundirse y dudar. Para la confección de la nube estas dos palabras se unieron ya que, en realidad, aparecían casi siempre juntos. Ejemplos de referencias a estas conductas son:

“se confunde explicando”

“se confunde y explica dudando”

“en la clase muchas veces se confunde y muestra dudas”

“duda y se confunde cuando le preguntas”

“no responde o duda”

Un concepto muy interesante que surge en el análisis es “sin prácticas”, que tiene dos vertientes. Por un lado, se refiere al hecho de que en las clases no se hagan más prácticas o no sean más prácticas y, por otro, a la aplicación práctica (o en la práctica) de lo tratado en el aula:

“no le vemos relación con la práctica”

“no poder poner el conocimiento adquirido en práctica”

“no reflejan ningún tipo de aplicación práctica”

“falta cómo poner en práctica lo que aprendemos en teoría”

“no consigue que interioricemos ese conocimiento poniéndolo en práctica”

Otra cuestión a destacar es que, revisados los contextos, esta idea está casi siempre vinculada al “leer”, que es otro de los verbos muy empleados para referirse al profesorado que no ayuda a aprender. De hecho, en buena parte de las apariciones forma la frase con “simplemente”.

“simplemente lee de un pdf con la teoría”

“simplemente lee de carrerilla sus apuntes”

“va simplemente a leer diapositivas”

“simplemente lee la presentación de la pantalla”

“simplemente lee el PowerPoint”

Lo que nos lleva a otro punto relevante, que es la cantidad de veces que aparece el nombre “PowerPoint”, que en la Figura 3 aparece bastante pequeño (y quizás difícil de leer), pero que es una de las palabras significativas del análisis. También se señalan bastantes veces, y de forma negativa, las “diapositivas” (por ejemplo, “pasar simplemente un par de diapositivas”), pero el mencionado programa, cuando aparece, está siempre asociado con aspectos negativos:

“aquel que solo lee los powerpoints”

“únicamente a leer un powerpoint”

“leer un pdf o un powerpoint no es dar clases”

“solo leía un powerpoint que yo podría leer en mi casa”

“solamente se dedican a leer presentaciones de powerpoint”

Finalmente, palabras que en una primera exploración parecían tener mucho peso, no han podido ser asociadas a ninguno de estos dos grupos, ya que aparecen con pesos similares en ambos contextos y no tan importantes como los comentados hasta aquí. Es el caso de “dudas” (en el sentido de aclararlas), “forma” (de dar clase o evaluar) y “trabajo” (generalmente del alumnado), por ejemplo.

6.Discusión

El objetivo de este estudio era indagar, mediante investigación cualitativa, sobre el significado de una pregunta del cuestionario de evaluación docente que contesta el alumnado, la cual, en análisis previos con técnicas de big data, resultaba ser el mejor predictor de la satisfacción global con el profesor o profesora. La ausencia de investigaciones similares no permite la comparación de los resultados con otros previos. No obstante, los hallazgos presentados parecen tener valor por sí mismos.

En la presente investigación, basada en análisis de textos apoyado por software, se partió de descripciones de más de 600 estudiantes universitarios acerca de qué significa que un/a docente “me ayuda a aprender” y en base a qué se valora esta cuestión cuando se requiere otorgar puntuaciones.

A partir de esas descripciones, se encontraron grupos de 6-7 nociones diferentes para explicar, separadamente, las valoraciones positivas y negativas, y se han mostrado algunas en el contexto de las frases en las que aparecen. Pero quizás el hallazgo más importante es que los conceptos que mejor muestran los polos positivo y negativo de “me ayuda a aprender” son “explica” y “se entiende”. Esto es: si se hace “bien” es algo muy positivo, mientras que si se hace “mal” es muy negativo.

Este aspecto es coincidente con una de las tres dimensiones en las que agrupan Sandoval et al. (2020) las opiniones de estudiantes de varios países (si bien en su caso son de primaria y secundaria): explicaciones docentes. Las otras son metodología y evaluación, lo que nos lleva a un punto de indudable interés sobre el que valdrá la pena incidir en futuras investigaciones: aunque en la primera exploración de los datos aparecía la palabra “examen(es)”, en los análisis subsecuentes no se encontró vinculación entre ellos y el ayudar, o no, a aprender.

Si bien se trataba aquí de obtener una primera aproximación a unos datos novedosos en lo que a la investigación sobre evaluación docente se refiere, los resultados pueden ser de utilidad e inmediata aplicación para mejorar la interpretación de los datos cuantitativos de que disponen un buen número de instituciones universitarias. También podrán emplearse para optimizar esta evaluación y los cuestionarios existentes e, incluso, reducir su longitud (que es una vieja aspiración de quienes diseñan, utilizan, analizan y tratan de sacar partido a las opiniones del alumnado para mejorar la calidad de la enseñanza o, más propiamente hablando, del binomio enseñanza-aprendizaje).

Por otra parte, a través de los análisis realizados ha sido posible aislar verbos conductuales o verbos de comportamiento, aplicados a los docentes. Estos verbos, que tanto se han relacionado con los objetivos de aprendizaje y la adquisición de competencias por parte del alumnado, podrían ser útiles a la hora de elaborar estrategias docentes y de proporcionar formación al profesorado, especialmente al novel. Esta sería una aplicación más allá de las encuestas de satisfacción del alumnado, que sin duda repercutiría en mejoras tangibles.

Esta investigación no soluciona el problema de establecer la calidad de la enseñanza a partir de los resultados de unas encuestas de opinión (Beecham, 2009; Galbraith et al., 2012; LERU, 2021; Spooren et al., 2013), pero permite interpretar mejor esos resultados aportando datos sobre la significación de términos que han mostrado tener especial relevancia. Además, al proporcionar aclaraciones sobre el significado de algunos conceptos clave, es posible que no sean tan necesarias ciertas acciones (véase Berk et al., 2004 y Hornstein, 2017), propuestas para mejorar la información que proporcionan los cuestionarios de evaluación que contesta el alumnado.

7.Consideraciones finales

Como se mencionó al inicio de este trabajo, desde hace algún tiempo, autores y organismos internacionales vienen alertando acerca de la utilización de la satisfacción del alumnado para evaluar la calidad de la enseñanza (véase, por ejemplo, la revisión de Hornstein, 2017). Ante la proliferación de cuestionarios muchas veces sin finalidades u objetivos claros, en este trabajo se ha intentado abrir una nueva vía para una mejor comprensión de las valoraciones de los y las estudiantes, que puede ayudar a operativizar una idea que se ha mostrado clave en esa satisfacción: “este/a profesor/a me ayuda a aprender” (o no).